La historia de NVIDIA es apasionante y nos ayuda a entender cómo una marca se ha convertido en un líder absoluto de su sector. Pudo con las Voodoo de 3dfx y con las famosas ATI Radeon, combatiendo ahora contra la todopoderosa AMD.

Las tarjetas gráficas son uno de los componentes de PC más importantes, especialmente si nos ponemos exigentes en términos de rendimiento. Si hablamos de GPUs, hay que hablar de NVIDIA, y repasar su historia puede ayudarnos a entender las causas de por qué tiene esa hegemonía en su sector durante tantos años sin que nadie pueda con ella.

Índice de contenidos

1993-1996: empieza la historia de NVIDIA con NV1

Partimos del 5 de abril 1993, el año en el que NVIDIA fue fundada por Jensen Huang, Chris Malachowsky y Curtis Priem. Por entonces, Jensen Huang había sido director en LSI Logic y diseñador de CPUs en AMD, ¡qué irónico! La idea de su fundación surge en que entendieron que el PC sería un dispositivo que se utilizaría para ejecutar juegos, músicas e imágenes.

Llegaron a dicha conclusión, entre otras cosas, porque los videojuegos se estaban volviendo complejos desde el punto de vista computacional. Así que, los videojuegos fueron el principal objetivo de la historia de NVIDIA a la hora de financiar estrategias de I+D

Nos enmarcamos en un año en el que ya habían 26 fabricantes de GPUs, y NVIDIA comienza con tan solo $40.000 de capital, pero pronto recibiría fondos de capital de riesgo: $20 millones para empezar en 1993, ¡no está nada mal! Al principio, no había un nombre comercial y los socios fundadores decidieron denominar a sus archivos «NV».

Nada más fundarse, comenzaron a trabajar en NV1: el primer producto de la compañía. Trabajaron en esta GPU 2 años hasta que fue lanzada en 1995 con una innovación principal: podía con vídeo 2D y 3D, además de tener un hardware para procesar el audio integrado. Atrajo tanto la idea de la NVIDIA NV1, que Sega decidió usarla en su consola Saturn, por lo que el equipo de NVIDIA desarrolló un soporte para Saturn.

La NVI hacía uso de un acelerador de gráficos que utilizaba superficies cuadráticas como geometría básica, lo que pronto puso en aprietos a los diseñadores de juegos, ¿por qué? Agregar el soporte de NV1 o diseñar juegos para ella. Tened en cuenta que, por aquel entonces, los juegos se diseñaban para una u otra gráfica, no es como ahora que todo es «más sencillo» porque existe AMD, NVIDIA y las APIs DirectX. Antes, teníamos a 3dfx, ATI y NVIDIA como marcas de GPUs.

Después de que Microsoft lanzara DirectX en 1996, su primera API, el problema se hizo mucho mayor: la NV1 usabas superficies cuadráticas y DirectX fue diseñada con polígonos. Entonces, las GPUs usaban la interfaz PCI-Express básica que proporcionaba 133 MB/s de ancho de banda. Veíamos frecuencias de hasta 75 MHz y resoluciones máximas de 1600×1200 con color de 16 bits.

A pesar de todo, la NV1 no fue triunfal, pero ayudó el hecho de que la Sega Saturn la integrara, junto con la creciente demanda de ordenadores personales. NVIDIA comienza su historia debiendo mejorar bastante para competir contra los demás, así que empieza a trabajar en la NV2. Sin embargo, la NV2 fue cancelada y Sega decidió irse con PowerVR para dotar a su Dreamcast de gráficos.

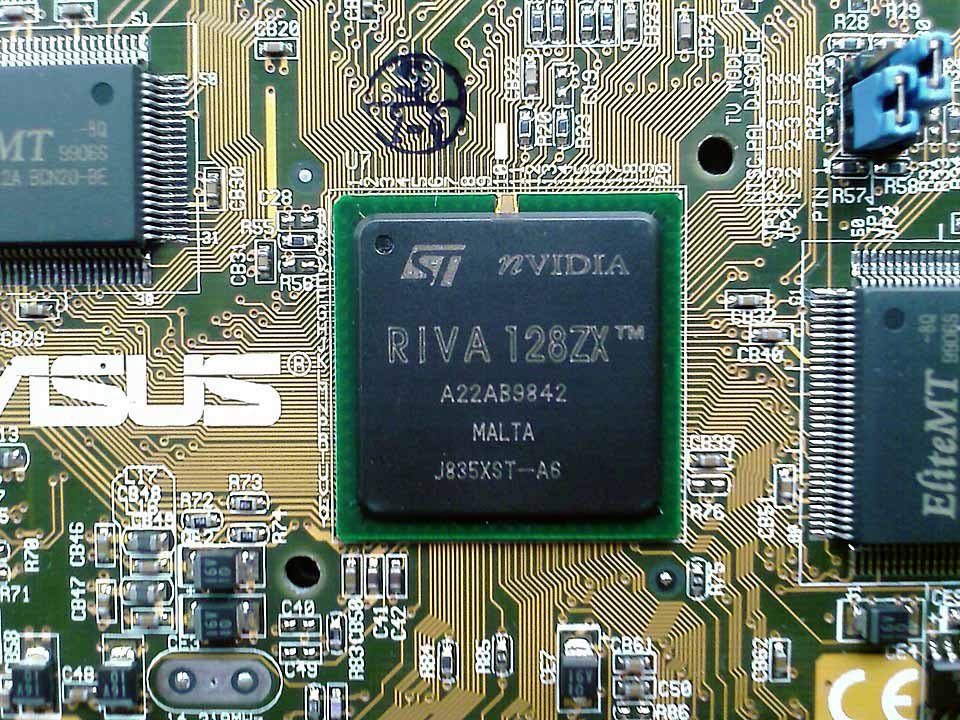

1997: el lanzamiento al estrellato con RIVA 128

La NVIDIA RIVA 128 que conocida como NV3 y fue una tarjeta gráfica que obtuvo mucho éxito porque dejó las cuadráticas para pasarse al polígono como geometría básica. La consecuencia de ello estaba en la facilidad de soportar Riva 128 en los juegos. Además, fue una tarjeta gráfica que usó el mapping de texturas poligonales con resultados mixtos: se reduce calidad de imagen, pero procesa los frames más rápido.

Vino con 2 variantes:

- Riva 128. Tenía 4 MB de memoria VRAM (SDRAM) y su frecuencia llegaba a los 206 MHz, haciendo uso de un bus de 128-bit.

- Riva 128ZX. Su memoria VRAM era de 8 MB y su frecuencia llegaba a 250 MHz. Era la versión tope de gama que venía con chips de mejor calidad, los cuales ofrecían más frecuencia RAMDAC.

NVIDIA hizo historia con esta GPU porque vendió 1 millón de unidades en los 4 primeros meses, ¡locura total! Su éxito fue el aumento de rendimiento, así como ser capaces de acelerar gráficos 2D y 3D.

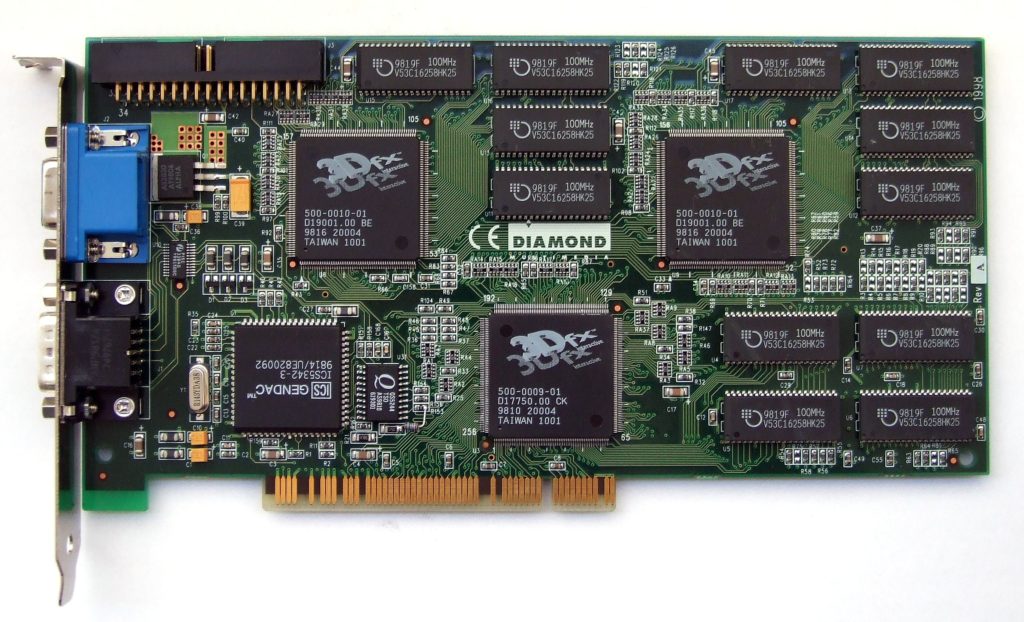

1998: NVIDIA detonó el fin de 3dfx con su Riva TNT

En su momento, hablamos de 3dfx como uno de los mejores fabricantes de tarjetas gráficas de la historia, que era la marca TOP de los 90. NVIDIA presenta su Riva TNT (NV4), cuyas mejoras eran las siguientes:

- Compatibilidad con color de 32 bits.

- VRAM de 16 MB (SDR SDRAM).

- Usaba PCI-Express.

- Depuración de drivers de cara a mejorar la compatibilidad y el rendimiento, dando lugar a los controladores «Detonator».

- Más soporte.

La GPU a «destronar» era la Voodoo2 de 3dfx, que era la más potente, pero con un «pero»: su compatibilidad de color era de 16 bits. A parte, era cara y necesitábamos una tarjeta gráfica 2D dedicada, así que usar una comportaba cierta inversión de dinero. Y es que la Riva TNT no necesitaba de otra GPU porque podía con 2D y 3D, además de que era más barata que la Voodoo2.

El equipo de NVIDIA quería que la Riva TNT superase a la Voodoo2 en frecuencia, pero el chip se calentaba una barbaridad, por lo que era impensable. Finalmente, tuvieron que lanzarla a 110 MHz, mucho más lenta que la Voodoo2.

Curiosamente, NVIDIA cierra un acuerdo con TSMC para la fabricación de las NVIDIA RIVA 128ZX y la TNT.

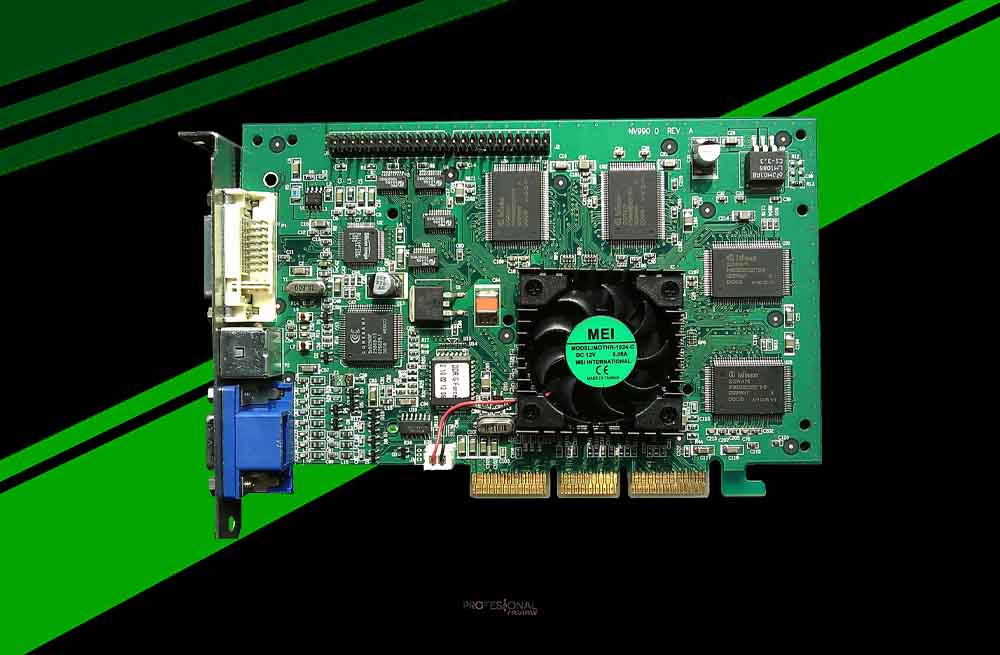

1999: con Riva TNT2, Quadro y la GeForce 256 nace la «GPU»

Con la consolidación de la NVIDIA Riva TNT en 1998, la compañía sigue con su Riva TNT2 (NV5), una GPU que es igual en todo salvo en determinados puntos:

- Motor de renderizado mejorado.

- Hasta un 17% más rápida a la misma frecuencia.

- Soporte para ranuras AGP 4X = más ancho de banda.

- Memoria VRAM de 32 MB.

- Proceso de 250nm.

- Frecuencia de 175 MHz.

Su rival era la Voodoo3, y lo cierto es que nunca quedó claro cuál ganó de las 2 porque ofrecieron un gran rendimiento en aquella época. Eso sí, la Voodoo3 sería el último gran producto de 3dfx, llegando a duras penas al siglo XXI.

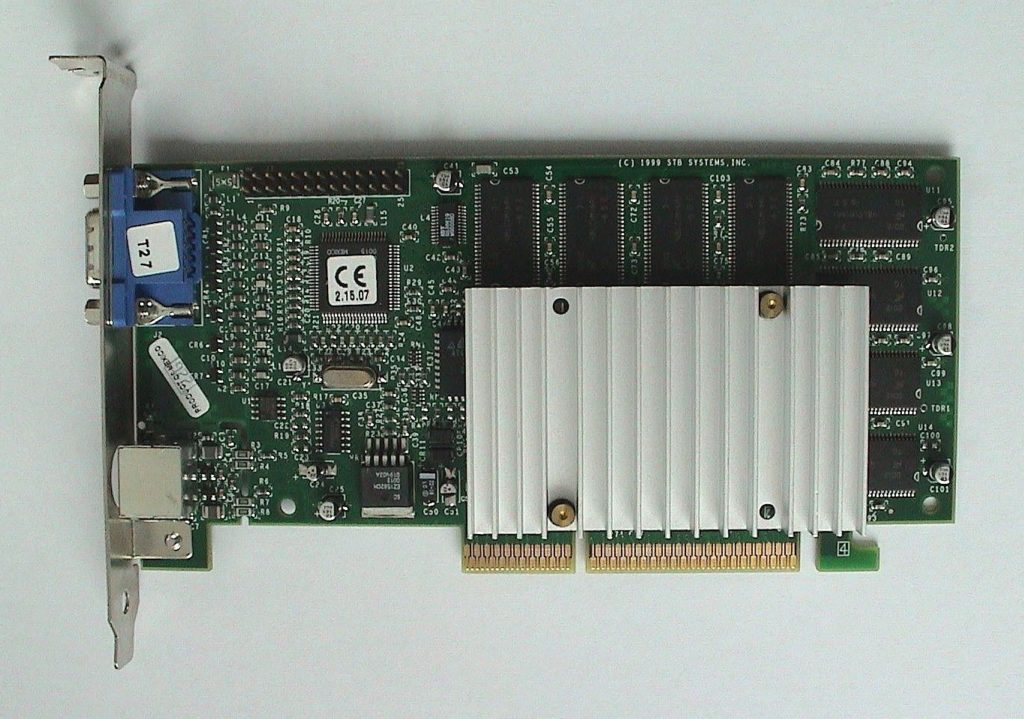

A finales de 1999, NVIDIA presenta la GeForce 256, y aquí hay que hacer un parón. Hasta ahora, todas las tarjetas gráficas eran consideradas «tarjetas de vídeo» y el término «GPU» llega con la GeForce 256, el cual fue acuñado por la misma compañía en su presentación.

¿Qué le diferencia del resto de tarjetas de vídeo? Según NVIDIA, define la GPU de la GeForce 256 de la siguiente manera:

Un procesador integrado en un chip que incluye motores de transformación, iluminación, configuración de triángulos/planos de corte y renderizado, y es capaz de procesar un mínimo de 10 millones de polígonos por segundo.

Realmente, lo más característico fue introducir el famoso «T&L«, que era un procesamiento de hardware relacionado con la transformación e iluminación. Esto permitió que la GPU realizara cálculos que hacía anteriormente la CPU, y es que el motor T&L tenía esa función específica.

Otra de las diferencias con la NVIDIA Riva TNT2 estaba en que contenía 4 tuberías de píxeles, mientras que la otra solo tenía 2. Debido a eso, la frecuencia tuvo que ser inferior a la de la Riva TNT2, pero no importaba porque era 50% más rápida.

La memoria VRAM de la GeForce 256 oscilaba entre 32 y 64 MB DDR (SDRAM), lo que era un aumento de rendimiento importante en la renderización. El proceso de fabricación del chip era de 220nm y veíamos una frecuencia de 120 MHz.

Aunque NVIDIA se centraba en los videojuegos, introdujo hardware de aceleración de vídeo para MPEG-2 únicamente. Más tarde, se preocuparían por los códecs, pero esa no era la lucha principal.

Decir que en 1999, NVIDIA introduce su primera GPU Quadro para el mundo profesional. Hoy, esta gama es conocidísima dentro del sector, siendo la más elegida por los profesionales de diseño.

2000: NVIDIA compra 3dfx, lanza la GeForce2 GTS y, ¿Xbox?

La historia de NVIDIA no había hecho nada más que comenzar porque se hacía oficial la compra de 3dfx en diciembre del año 2000, así como la primera GPU portátil GeForce2 Go, como también la colaboración con Xbox: NVIDIA montaría la GPU de la primera consola de Microsoft.

Decir que el hardware que usó la Xbox fue casi idéntico al que usaban los PCs (como ha ocurrido con la PS5 o Xbox Series X/S), siendo la elegida una GeForce3. Esta tarjeta gráfica es parecida a la NV20 y otra de las novedades fue el audio hardware MCPX.

En este mismo año, NVIDIA evolucionó de la GeForce 256 a la GeForce2, que vendría con una arquitectura parecida a la anterior y fue lanzada en el verano del 2000. La diferencia estaba en que ofrecía el doble de TMUs gracias a la evolución al proceso de 180nm.

Vimos 3 núcleos distintos en la GeForce2: NV11, NV15 y NV16, todas usaban la misma arquitectura. Sin embargo, la NV11 venía con solo 2 canalizaciones de píxeles, mientras que las otras dos tenían 4. La NV16 era la más potente y funcionaba a más frecuencia que la NV15.

Se empezaba a incluir como «característica» que la GeForce2 soportara varios monitores simultáneamente; de hecho, era la primera línea de GPUs NVIDIA en hacerlo. Todas las GeForce2 eran compatibles con memorias SDR y DDR.

Fue en diciembre del año 2000 cuando NVIDIA era elegida para desarrollar los gráficos de la Xbox, lo que le hizo ganar $200 millones.

2001: gráficos integrados nForce y GeForce3

Vivíamos en una época de muchos cambios en la informática: cada año salían muchas cosas nuevas. Así que, en 2001, llega la NVIDIA GeForce3 (NV20), que sería la primera GPU de la marca en ser compatible con DirectX 8.

La GPU venía con un proceso de fabricación de 150nm, permitiendo equipar 60 millones de transistores que funcionarían a una frecuencia máxima de 250 MHz. Esta GPU trajo una novedad bajo el brazo: LMA (Ligthspeed Memory Architecture), un subsistema de memoria cuyo objeto era comprimir el búfer «Z» y reducir la demanda general en el ancho de banda de la memoria.

También, favorecía la aceleración FSAA usando Quincunx, un algoritmo especial. Todo esto se traduce en un rendimiento más potente que la GeForce2, pero empezábamos a ver un precio mucho más alto (eran más caras de producir).

La NVIDIA GeForce3 era la primera GPU programable de la historia, y, gracias a ello, los desarrolladores de juegos podían crear efectos visuales personalizados. Por último, destacar la aparición de NVIDIA nForce: los primeros gráficos integrados de la marca.

2002: NVIDIA GeForce4 y diversas adquisiciones

Ya empezado el siglo XXI, NVIDIA agita la coctelera para introducir varias GPUs basadas en distintas arquitecturas:

- NV17. Pertenece a la familia GeForce4 y era de gama baja. Realmente, era una GeForce 2 NV11 a la que se le había practicado una evolución en la litografía, usando 150nm y una frecuencia que oscilaba entre 250 y 300 MHz.

- NV18. Era un refrito de la NV17, pero que tenía un bus AGP x8.

- NV19. Se trataba de una NV18 con un PCIe bridge que soportaba 16 carriles.

Las 2 últimas tenían memorias DDR que funcionaban a una frecuencia entre 166 y 667 MHz. Sin embargo, el lío comienza cuando NVIDIA lanza la NV25 para tener una gama alta en el mercado. Esta tarjeta gráfica venía con la arquitectura GeForce3, viniendo con 8 TMUs y 4 ROPs.

En cambio, la NV25 venía con 63 millones de transistores, el doble de sombreadores de vértices y el sistema LMA-II. La frecuencia también mejoraba, llegando a 300 MHz, mientras que el memory clock de sus 128 MB DDR llegaba hasta 650 MHz.

Las ganancias de rendimiento no superarlo el 10% de forma genérica en los videojuegos que funcionaban con la API DirectX 7. La cosa cambia en DirectX 8: la NV25 sacaba hasta un 38% más de rendimiento, ¡brutal!

Después, decidió lanzar el NV28, un chip que era calcado al NV25, pero que traía soporte AGP x8.

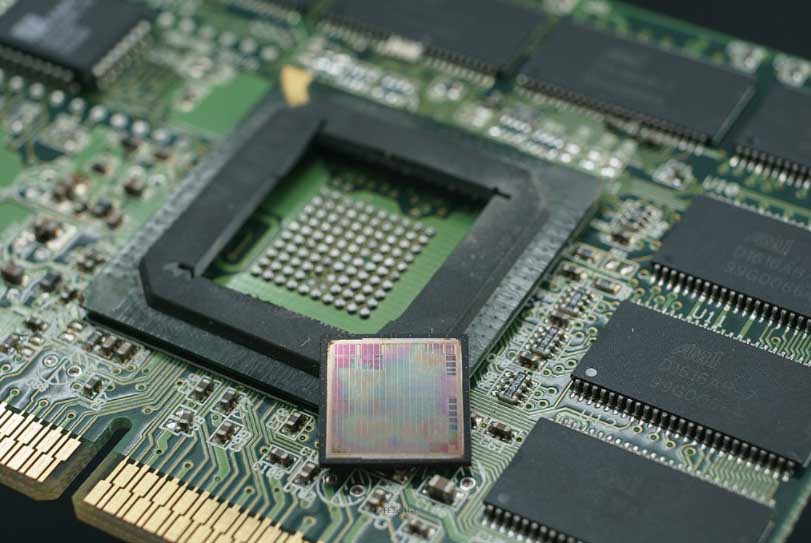

Finales de 2002, NVIDIA contraataca a ATI con la FX 5000

Llega DirectX 9 al mercado y empieza una batalla encarnizada entre ATI y NVIDIA: la lucha por sacar GPUs compatibles con dicha API. Esta batalla era a contrarreloj y es que había que soportar Pixel Shader 2.0. ATI dio el golpe en la mesa y ganó inicialmente la batalla en verano de 2002: las primeras tarjetas gráficas compatibles con DirectX 9.

A finales de 2002, NVIDIA contraataca con su serie FX 5000 (recuerda a las CPUs AMD), y para compensar esa tardanza sacó algunas características extras:

- Pixel Shader 2.0A. Tenía varias mejoras sobre la base de Microsoft (texturas dependientes ilimitadas, más cantidad de espacios, soporte para gradientes, etc.). La verdad que NVIDIA convenció y todas estas mejoras se incluyeron en el Pixel Shader 3.0.

- Las FX 5000 (NV30) tenían un proceso de 130nm:

-

- Frecuencia entre 400 y 500 MHz.

- Memoria RAM DDR2 de 128 a 256 MB.

- Memory clock de 800 a 1000 MHz.

- Bus de memoria de 128-bit.

- 8 TMUs y 4 ROPs.

-

Meses después, vio la luz el modelo más potente de la FX 5000: usaba un sombreador de vértices adicional y DDR3 junto con un bus de 256-bit. Aun así, era la primera derrota seria de la historia de NVIDIA por lo siguiente:

- Peor rendimiento que ATI.

- Peor refrigeración.

Con todo esto, NVIDIA estaba en otras labores, como era la adquisición de Exluna, una desarrolladora de programas para renderizar. A estas alturas, NVIDIA ya había vendido 100 millones de chips gráficos.

2003: compra de MediaQ y la NVIDIA GeForce 6800

NVIDIA se rehace de un mal año y lanza la GeForce 6800 (AMD ha utilizado un naming parecido en sus RDNA 2 de 2020) como el flagship de la familia con una GPU NV40. Llegaba a los 222 millones de transistores (130nm), tuberías superescalares de 16 píxeles, 6 sombreadores, compatibilidad con Pixel Shader 3.0 y 32-bit floating-point.

Los juegos empiezan a demandar mucha memoria VRAM y esta ofrecía hasta 512 MB GDDR3 con un bus de 256-bit. En cifras de FPS, era el doble de rápida que la FX 5950 Ultra y un 50% más rápida en la mayoría, así como consumir menos energía.

Aparte, NVIDIA adquiere MediaQ por $70 millones, una empresa líder en gráficos y tecnología multimedia.

2004: SLI, PS3 y NVIDIA GeForce 6600

En 2004, vemos como NVIDIA hace uso de la patente registrada de 3dfx: SLI, que permitía conectar 2 o más GPUs simultáneamente. Este año está plagado de noticias, como es la colaboración con Blizzard en World of Warcraft: el MMO más increíble de la historia.

No solo eso, también ayudó a la NASA para renderizar y reproducir el suelo de Marte a través de los datos que habían recibido del robot Rover. Transformaron todas las imágenes en realidad virtual para ayudar a los científicos.

En este mismo año, NVIDIA adquiere iReady como proveedor de alto rendimiento TCP/IP e iSCSI. También, asistió a Sony en el diseño del procesador de gráficos RSX que llevaba la PlayStation 3, la última consola del next-gen real.

¿Y qué hay de las GPUs? Hablemos del chip NV43, enfocado en la gama media y que se usó en la NVIDIA GeForce 6600. Contaba con la mitad de hardware que la NV40, pero vimos alguna novedad:

- Proceso de 110nm.

- Más barata de producir.

- Menos consumo de energía.

- Más reloj.

Realmente, este año NVIDIA decidió tomarse las cosas con calma para atacar «con todo» en 2005.

2005: comienza la historia de NVIDIA GTX

La historia de NVIDIA GTX nace con las 7800 GTX y 7800 GTX 512, 2 tarjetas gráficas que introducían un cambio de rendimiento brutal. Inicialmente, la 7800 GTX sustituía a la GeForce 6800, su proceso era de 110nm y contaba con 24 TMUs y 16 ROPs. Además, veíamos sus 256 MB GDDR3 (256-bit) funcionando hasta 600 MHz, mientras que el memory clock se quedaba a 1.200 MHz.

Su GPU era la G70, pero su gran potencia no convencía a NVIDIA, por lo que sacó la GeForce 7800 GTX 512, una tarjeta gráfica con 512 MB de memoria VRAM que venía con un núcleo rediseñado. Las temperaturas eran mejores y su controlador de memoria reducía la latencia porque el bus de memoria era de 512-bit. El memory clock llegó a 850 MHz.

Mientras tanto, NVIDIA adquiría ULI Electronics, un proveedor de componentes (piezas para chipsets) de ATI.

2006: la arquitectura CUDA aterriza y AMD compra ATI

2006 fue el año en el que aterrizó la arquitectura CUDA, que revolucionó el cálculo en la GPU. Unos de los beneficiados eran los científicos que manejaban una cantidad de datos abismal, por lo que se aprovecharon de la capacidad de procesamiento paralelo de las GPUs.

NVIDIA ya había vendido 500 millones de chips y adquirido HYBRID graphics, una desarrolladora de programas de renderizado 2D y 3D para móviles. Además, AMD compra ATI el 24 de julio de 2006 por un precio de 5.400 millones de dólares.

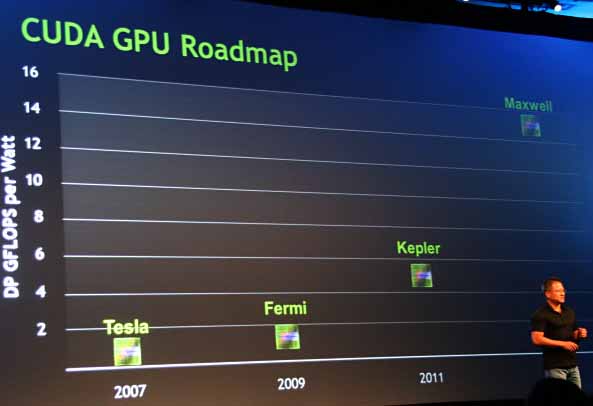

2007: NVIDIA GeForce 8000 y nace Tesla

A pesar de que CUDA se hubiese anunciado, NVIDIA presenta en 2007 sus tarjetas gráficas GeForce 8000, que estaban basadas en Tesla. Esta arquitectura estaría en el mercado hasta las GeForce 300 GTX.

En el caso de las GeForce 8000, el flagship era la 8800 GTX que equipaba lo siguiente:

- GPU G80 basada en 80nm con arquitectura Tesla.

- Más de 681 millones de transistores.

- Soporte de DirectX 10 y Pixel Shader 4.0.

- 768 MB GDDR3 a 384-bit.

- 64 TMUs y 24 ROPs.

Más tarde, llegó la 8800 Ultra como modelo más potente de la familia, cuya mejora era la frecuencia: 612 MHz vs 575 MHz. Con todo esto, NVIDIA se mete en el sector profesional con su primera GPU Tesla, enfocada para científicos.

NVIDIA llevaba varios años sacando tarjetas gráficas que doblaban el rendimiento de la generación anterior, una brutalidad.

En 2007 NVIDIA adquirió 2 empresas TOP:

- PortalPlayer, Inc.

- Ageia, desarrolladora del motor gráfico PhysX y la unidad de procesamiento física, ¿os suena de algo?

2008: NVIDIA Tegra, GeForce 200 y 9000

Con GeForce 9000 también se uso la arquitectura Tesla, pero NVIDIA tocó varias cosas:

- La GPU G92 era más pequeña que la G80 porque su litografía era de 65nm.

- Sus frecuencias iban hasta 675 MHz.

- El consumo de energía se reducía bastante, también su calor.

Eso sí, vimos llegar la GeForce 9800 GX2, que equipaba 2 GPUs G92 y era el modelo insignia de la familia. Comparando la 8800 Ultra vs 9800 GX2, se vieron unas mejoras de rendimiento hasta el 41% de rendimiento, pero solo cuando el anti-aliasing estaba desactivado. Por tanto, se concluyó que solo mejoraba un 13% de rendimiento.

¿Y por qué tan poco si era una GPU dual? Básicamente porque cada G92 accedía a 512 MB GDDR3, mientras que la 8800 Ultra equipaba 768 MB. Decir que no se vendió mucho esta 9800 GX2 porque era muy cara.

La cosa no se frenó para NVIDIA y lanzó otra GeForce 9800 GTX con una GPU G92 y 512 MB GDDR3. La novedad estaba en su mayor frecuencia y en que su die venía con un proceso de 55nm, de ahí que la denominarán G92B. Dicho esto, las características principales fueron su 1 GB de memoria VRAM y su frecuencia de 738 MHz como máximo.

¿Creéis qué NVIDIA se quedó tranquila? Pues no, lanzó su serie GeForce 200 con arquitectura Tesla y una GPU nueva: la GT200. Aquí vimos muchas innovaciones interesantes a nivel de desarrollo técnico:

- Incluía un programador mejorado y un conjunto de instrucciones.

- Su interfaz de memoria era más amplia y se había modificado la relación de núcleos.

- La GT200 equipaba 24 EUs y 32 ROPs.

- El bus de memoria era de 512-bit.

- El modelo insignia era la GTX 280, que fue más rápida que la 9800 GTX, pero no superó a la GPU dual de la 9800 GX2.

Ante esto, NVIDIA introdujo la GTX 295 con 2 GPUs GT200 en 2009 para sustituir la GX2. Por último, NVIDIA lanza el primer procesador Tegra, una familia que se ha extendido hasta llegar a ver la Nintendo Switch equipar un SoC Tegra.

La polémica legal de las GPUs defectuosas

En 2008, NVIDIA redujo sus ingresos en $200 millones tras salpicarle una polémica de GPUs con defectos de fábricas. La marca no desveló qué tarjetas gráficas estaban afectadas y recibió una demanda colectiva que se resolvería en su contra en 2010: tenía que reembolsar el dinero a los propietarios de los portátiles afectados, o sustituirlos.

Además, NVIDIA decidió firmar un acuerdo de licencia cruzada con Intel para poner fin a todos los litigios que subsistían entre ambas empresas.

2009: el «big bang» del Deep Learning y Fermi

Por un lado, hay que decir que la era de la Inteligencia Artificial y del Deep Learning empezó mucho antes. Una empresa visionaria a largo plazo debe contemplar lo inusual, y estas tecnologías lo eran, así que NVIDIA invirtió en ellas.

Las tarjetas gráficas NVIDIA usan el Deep Learning a través de la API CUDA, la cual ayuda a los programadores a optimizar el uso de los núcleos para paralelizar programas. Es esta paralelización la que puede provocar ese aumento abismal de la velocidad de «training» de los algoritmos Deep Learning. Así que, NVIDIA participó en el «big bang» del Aprendizaje Profundo, dejando por escrito lo siguiente:

Cuando las redes neuronales de Deep Learning se combinaron con las unidades de procesamiento de gráficos de NVIDIA.

NVIDIA también se metía de lleno en el mundo Android, trabajando con Google para implementar dicho sistema operativo en las GPUs Tegra. Fue en el mismo GTC de 2009 de NVIDIA cuándo se anunció la nueva arquitectura Fermi, la cual sustituía a Tesla y se empezó a usar en las GeForce 400.

2010: GeForce 400 con el carro de DirectX 11

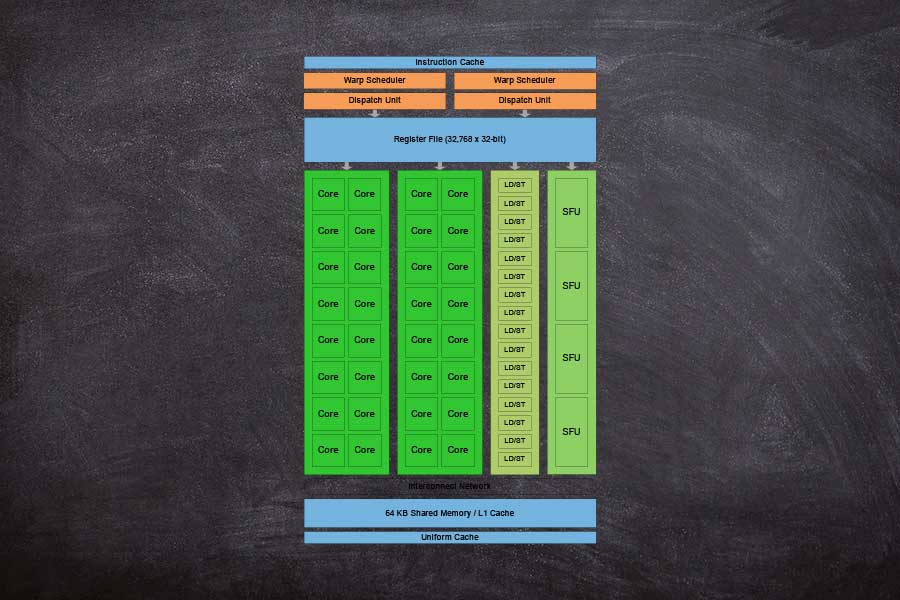

En efecto, NVIDIA da otro paso en su historia con GeForce 400 al sumarse al DirectX 11, una API que inicia una nueva generación en lo que a gráficos se refiere. La arquitectura era Fermi y el chip más grande fue el GF100, que venía con 4 GPC:

- Cada GPC tenía 4 SM con 32 núcleos CUDA, 4 TMUs, 3 ROps y un motor PolyMorph.

Traducido en datos prácticos, una GPU GF100 venía con 512 núcleos CUDA, 64 TMUs, 48 ROPs y 16 motores PolyMorph. Si os fijáis, estamos hablando de la aparición de los núcleos CUDA por primera vez en una GPU, siendo la más potente de su generación la GTX 480.

Su DIE era de 529 mm², pero NVIDIA tuvo un problema: sacar GPUs perfectas era muy complicada por lo que no vimos esos 512 núcleos CUDA, sino más bien 480 en esta GTX 480. Además, este chip era muy caliente, por lo que los ensambladores tuvieron que montar ventiladores ruidosos para poder compensarlo.

¿Qué ocurrió con estas tarjetas gráficas basadas en Fermi? Que eran muy caras de producir y NVIDIA decidió reorganizar sus SM. Salieron varias GPUs como la GF104, 106 o la 108 en las que NVIDIA reorganizó sus SM para que fueran menos caros de producir.

Básicamente, se logró aumentar los CUDA cores, los TMUs y los ROPs por cada SM fabricado.

2011: GeForce 500 con la arquitectura Fermi renovada

Entrados en esta década de la historia de NVIDIA, la compañía decide seguir con Fermi para su generación GeForce 500. Se mejoró su proceso de fabricación porque se usaban transistores más lentos, pero más eficientes, mientras que los transistores más rápidos eran instalados en zonas clave para el rendimiento.

Con ello, se logró reducir el consumo de energía y aumentar la frecuencia: la GPU más potente fue la GF110, que potenció la GTX 580. El cálculo FP16 y Z-cull también fueron optimizados para mejorar su eficiencia.

La GTX 580 era mucho más rápida que la GTX 480 debido a que se habilitaron 16 SM en la GF110.

Otros acontecimientos que ocurrieron en 2011:

- Lanzamiento de Tegra 3 ARM para móviles.

- Adquisición de Icera por $367 millones.

2012: llega NVIDIA Kepler con las GTX 600

Con las GTX 600 lanzadas en 2012, NVIDIA escribe otro capítulo para la historia con Kepler, una arquitectura que fue utilizada bajo las GPUs «GK», que tenía un proceso de 28nm. La más potente fue la GTX 680, que utilizaba la GK104 con el doble de TMUs y el triple de núcleos CUDA que la GF110 de las GTX 400.

El rendimiento aumentó entre un 10-30% dependiendo del juego, pero lo que se aumentó mucho más fue la eficiencia.

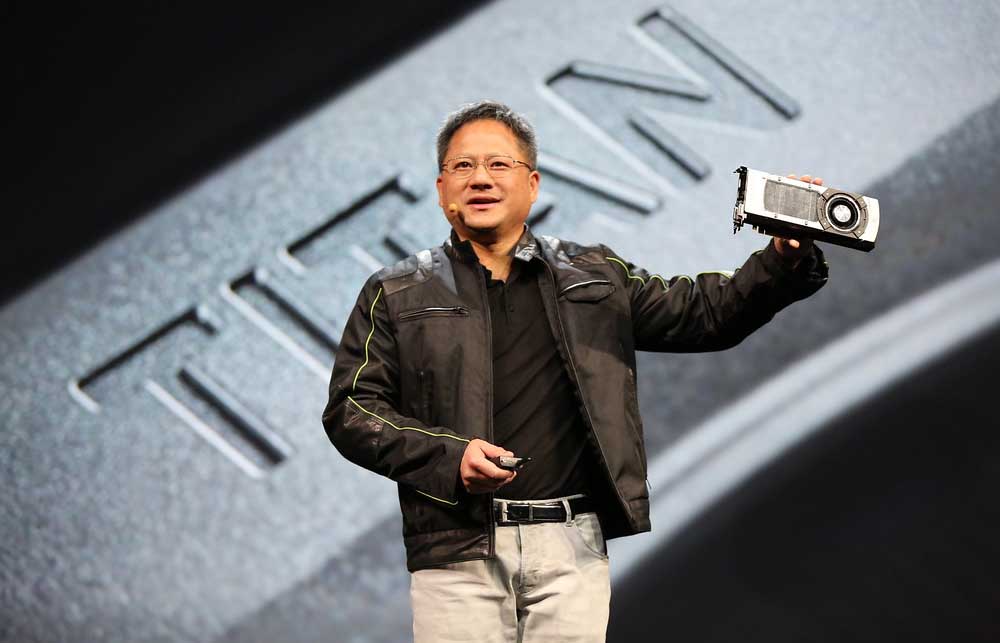

2013: GTX 700, un «refrito titánico» de Kepler

En la prensa se planteaba la generación NVIDIA GTX 700 como uno de los mayores refritos de la historia, pero, ¡vaya refrito! Podríamos decir que fue una de las grandes familias de la marca, caracterizada por tener un die más grande.

Dentro de la misma familia, vimos la GK110: la GTX Titan. Esta GPU aterrizaba en el mundo de los superordenadores, ofreciendo 2880 CUDA cores y 240 TMUs. NVIDIA tiró la casa por la ventana y la puso a la venta por unos $1000, un precio demasiado alto para la época. Eso sí, la GK110 venía «capada» y no contaba con todos esos núcleos CUDA.

Más tarde, la reintroduciría como la GTX 780, pero con 3GB de VRAM y un precio más decente. Llegaríamos a ver la GTX 780 Ti aterrizar en el mercado, y esta vez utilizaría los 2880 CUDA cores y 240 TMUs que disponía la GK110.

En 2013, NVIDIA lanzó el SoC Tegra 4 y compró la empresa PGI. Sin embargo, quisieron publicar documentos enfocados a los programadores, algo que nunca había hecho.

2014-2015: NVIDIA vuelve hacer historia con Maxwell

Un año después, Maxwell llegaría como una propuesta para mejorar la eficiencia de Kepler, así que se convirtió en una arquitectura imbatible en lo que a GPUs gaming se refiere. La buque insignia fue la GeForce GTX 980, que equipaba la GPU GM204, pero la GTX 980 Ti le sustituiría como punta de lanza.

Destacar el gran rendimiento que ofreció la GTX 970, convirtiéndose en un modelo de 4 GB que fue un éxito en ventas. Una de las diferencias entre Maxwell y Kepler fue el subsistema de memoria, y es que la GTX 980 traía un bus de memoria de 256-bit que se optimizó a través de un algoritmo de compresión de memoria.

Concretamente, la GTX 980 tenía 2048 núcleos CUDA, 128 TMUs y 64 ROPs. En términos de rendimiento, poca diferencia respecto a la GTX 780 Ti, pero sí hay que decir que su consumo se redujo casi a la mitad.

La GTX 980 Ti fue lanzada con casi 3000 núcleos CUDA para convencer a los usuarios de Kepler, pero consumía bastante energía.

Además, NVIDIA lanzó la tablet SHIELD, y podemos decir que no fue un éxito precisamente. Entonces, las tablets tenían mucho sentido porque los portátiles eran más aparatosos que ahora.

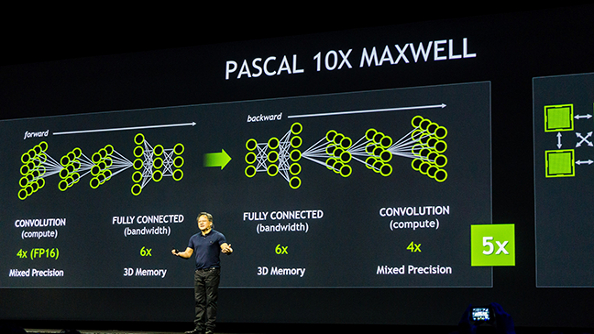

2016: Pascal es imparable y la IA llega para quedarse

Podemos decir que una de las arquitecturas más importantes de la historia de NVIDIA es Pascal, la cual vino con chips que seguían un proceso de fabricación FinFet de 16nm. Directamente, se mejoró la eficiencia y se subió la frecuencia, siendo la GTX 1060 una de las tarjetas gráficas más vendidas de la historia.

La GPU más potente era la GP104, cuya die tiene una superficie de 314 mm² y potenciaba la mítica NVIDIA GeForce GTX 1080. Llegábamos a contar con 7.200 millones de transistores, 2560 núcleos CUDA, 160 TMUs, 64 ROPs y 20 motores PolyMorph.

Como consecuencia, el cambio generacional fue evidente y la potencia de la GTX 1080 superaba con creces a la GTX 980. De hecho, fijaros si fue tan buena generación, que todavía se venden GeForce 1050 y 1050 Ti.

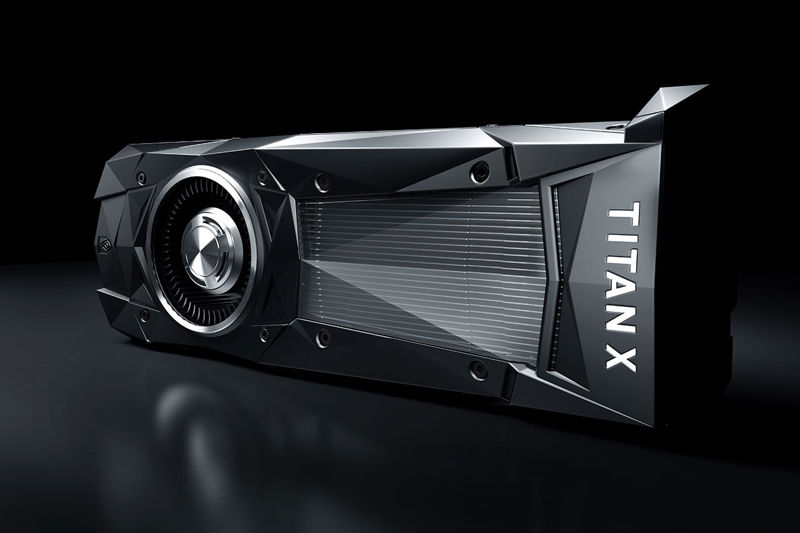

Con esta generación empezábamos a ver como algo normal que una GPU tuviese 8 GB de memoria VRAM, incluso la GTX 1080 Ti vino con 11 GB GDDR5X. Mientras la gama GeForce se vendía «como churros», NVIDIA lanzaba la GPU más potente de la historia (en aquel momento): la GTX Titan X.

Otro hecho importante es que vimos modelos montando memorias GDDR5X y GDDR5, diferenciando las distintas gamas. Además, empezábamos a ver los portátiles gaming en plena acción, montando GPUs Pascal bajo el diseño «Max-Q», el cual sigue con nosotros.

Era una bestia con 12 GB GDDR5X, 3072 CUDA Cores, hasta 1075 MHz y un bus de memoria de 384-bit. Y es que NVIDIA se centra de lleno en la Inteligencia Artificial con Pascal, DGX-1 y Drive PX 2.

A partir de aquí, NVIDIA pasa de lanzar una nueva generación de tarjetas gráficas cada año, a tardar 2 años en lanzar la siguiente. Todavía no sabíamos nada, pero los de Jensen Huang estaban trabajando en una tecnología llamada Ray Tracing, la cual sería el plato fuerte de la siguiente generación de GPUs.

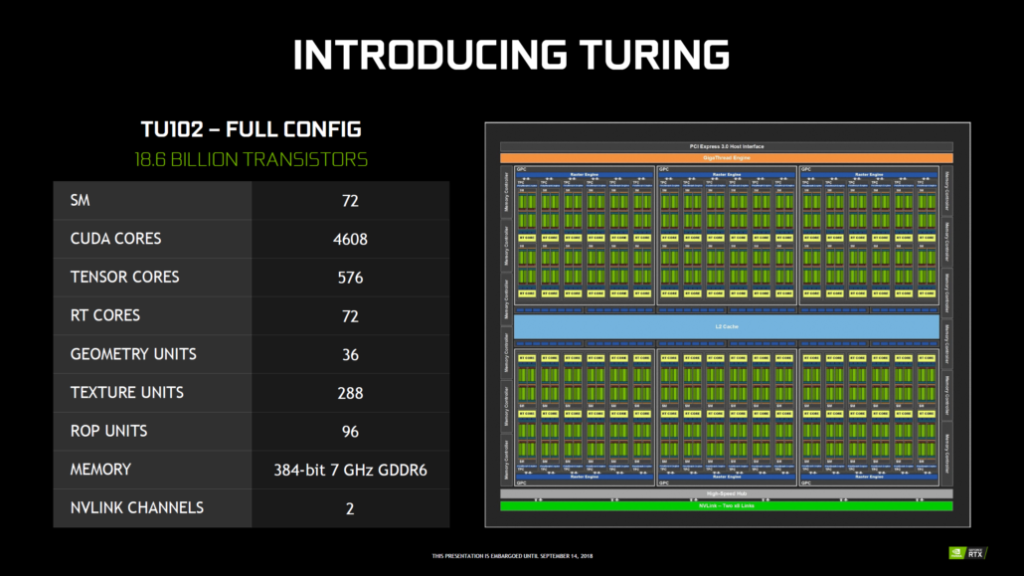

2018: NVIDIA presenta el Ray Tracing con Turing

La antesala de la presentación de la arquitectura Turing está en que NVIDIA ya había apostado de forma oficial por la Inteligencia Artificial y el Deep Learning en GPUs. Muestra de ello es la arquitectura Volta, el superordenador Jetson X2, NVIDIA Isaac o la tecnología Google Assistant.

Jensen Huang presenta la arquitectura Turing bajo el apodo del «Santo Grial» de la industria de tarjetas gráficas. Si «flipamos» con Pascal, con Turing volveríamos a hacerlo, y es que no era una arquitectura cualquiera: habían trabajado 7 años en ella. Se puede decir honestamente que es una de las mejores generaciones de tarjetas gráficas de la historia de NVIDIA.

¿Por qué? Se introduce el trazado de rayos denominado como «Ray Tracing«, y para hacerlo viable presentan los Tensor Cores y los RT Cores, 2 grupos de núcleos nuevos que están enfocados para procesar y renderizar gráficos. No obstante, los RT Cores son unos núcleos con un único fin: las operaciones de Ray Tracing.

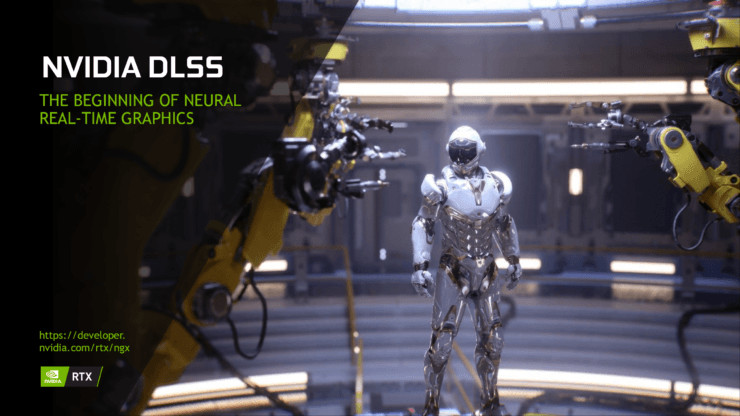

No solo se necesitaba una cantidad ingente de hardware para hacer viable una experiencia Ray Tracing en gaming, sino que se requería una optimización de software. Así se presentó NVIDIA DLSS, una tecnología que renderizaba un frame a baja resolución para reescalarlo a una resolución alta con la finalidad de que la GPU trabajase menos y se lograsen más FPS. Todo ello era posible gracias al uso de IA y Deep Learning.

Esta tecnología fue clave para hacer viable el Ray Tracing, pero contaba con 2 limitaciones importantes:

- Los juegos tenían que soportar Ray Tracing de forma individual. Esto supuso que muy pocos juegos soportaran Ray Tracing en un principio.

- Lo mismo ocurría con DLSS: no todos los juegos permitían este ajuste gráfico.

A ello, había que añadirle el querer jugar usando Ray Tracing a una resolución superior de 1080p: algo muy complicado. Turing fue la generación más innovadora, pero no fue una familia perfecta porque todavía se requería trabajar en este aspecto.

Primero, NVIDIA lanzó sus RTX Quadro enfocadas para profesionales, dando lugar a las GeForce RTX después: RTX 2080, 2080 Ti y 2070. NVIDIA pretendía conquistar a los gamers con 2 bazas:

- Las generaciones anteriores no disponían de Ray Tracing

- El aumento de rendimiento de la RTX 2080 sobre la GTX 1080 podía llegar al 125%, ¡brutal!

Por otro lado, el precio de esta familia de tarjetas gráficas se había aumentando y veíamos una RTX 2080 Ti a más de 1200€, lo que era una locura. Tened en cuenta que la GTX 1080 Ti no superaba los 800€, por lo que la única baza real de NVIDIA era el aumento de rendimiento.

En las tarjetas gráficas Turing vimos el conector VirtualLink, que era un USB-C enfocado al uso de gafas de realidad virtual. También, vimos NVLink para reemplazar a SLI con el objeto de eliminar el cuello de botella en PCI-Express.

Todas estas mejoras de una generación a generación constituían un aumento de precio brutal, por lo que NVIDIA fue duramente criticada por ello. También fue criticada por lanzar la RTX 2060 con un rendimiento pobre en Ray Tracing.

Para compensar, NVIDIA lanzó modelos SUPER en las RTX 2060, 2070 y 2080, siendo todos realmente interesantes. Eso sí, la RTX 2080 Ti era el modelo más potente en gaming, pero las RTX 2060 y 2070 SUPER se vendieron muy bien.

A NVIDIA se le dio bien este capítulo de su historia, pero cuidado con AMD porque llevaba escalando posiciones y conquistó a muchos consumidores con su RX 5700 XT.

Por último, decir que Microsoft logró hacer viable ese Ray Tracing de NVIDIA a través de su API DirectX 12, que luego veríamos una versión avanzada denominada «Ultimate».

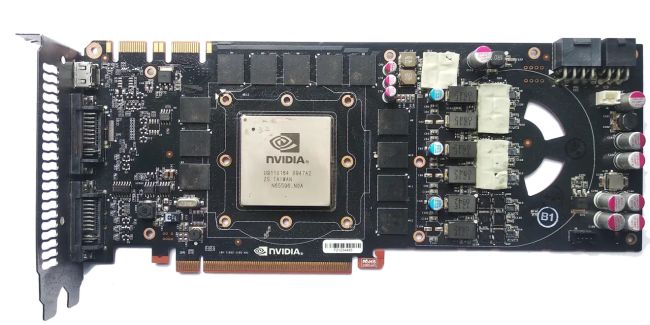

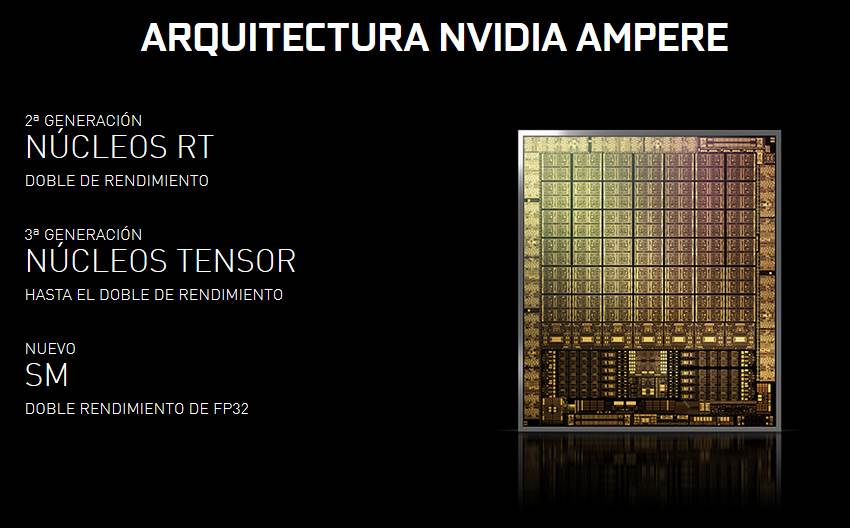

2020: Ampere hace viable el Ray Tracing a altas resoluciones

Ampere hacía realidad los sueños de NVIDIA: mejoraba a Turing en todo. Se produjeron muchas filtraciones sobre esta generación, y NVIDIA enseñó Ampere por primera vez en su GTC 2020. Mientras que el evento se producía a principios de 2020, las RTX 3000 no llegarían hasta finales de año.

¿Qué decir de este año? Llegó la pandemia del COVID-19 para quedarse hasta 2021, lo que supuso un golpe brutal a las empresas tecnológicas. Podría decirse que es uno de los peores años del siglo XXI, pero centrémonos en la historia de NVIDIA.

En Profesional Review, comparábamos el salto de Turing a Ampere como el que se produjo desde las GTX 200 a las GTX 400. Para no hacer eterna esta sección, en resumen cabe destacar todo lo que trajo Ampere.

- Memoria GDDR6X, desarrollada en exclusiva con Micron. Solo NVIDIA equiparía estas memorias.

- Proceso de fabricación de 8nm de Samsung.

- Disipador Founders Edition innovador con un ventilador en cada lado.

- Conector PCIe de 12 pines que no tuvo mucha trascendencia en la práctica.

- 80% más de rendimiento que la RTX 2080 Super.

- La llegada de NVIDIA Reflex.

- Mejoras contundentes en la latencia.

- Tensor y RT Cores de 3ª y 2ª generación.

- Nueva NVIDIA GeForce RTX 3090, con 24 GB GDDR6X y más de 10.000 CUDA Cores.

- El Ray Tracing ya era viable en 1080p a 144 FPS, pero todavía hay que trabajar en 2K y 4K.

- Más consumo, pero manteniendo la temperatura a ralla.

- Desaparecen los modelos SUPER y vuelven los Ti.

- La RTX 3060 ofrecía un rendimiento muy cuestionable, siendo superada por la RTX 2070 Super en ciertos aspectos.

- NVLink de 3ª generación.

- Se suprime el SLI, dejando a los desarrolladores de juegos a que lo hagan nativo.

- Surge el DLSS para profesionales: herramientas de modelado y renderizado 3D.

- NVIDIA refuerza sus herramientas Reflex y Broadcast.

Sorprendió tanto el rendimiento de AMD RDNA 2 que hicimos una comparativa enfrentando a las RTX 3000 vs RX 6000. Las GPUs NVIDIA seguían por delante, pero por muy poca diferencia, aunque en Ray Tracing dejaban claro qué marca tiene más experiencia.

A pesar de todo lo mencionado, esta familia se vio salpicada por una gran polémica: la escasez del stock. Ocurrió lo mismo con Pascal cuando el Bitcoin apareció en nuestras vidas y muchos mineros compraban GTX 1080 de 2 en 2. Ahora, el auge era Ethereum, otra criptomoneda que ocasionaba la «locura» en la demanda de tarjetas gráficas.

TSMC y Samsung no dan abasto en la producción de chips GPUs y los distribuidores ofrecen precios bastante más altos que los que anunciaban NVIDIA o AMD. Esto dio lugar a un mercado sumergido de revendedores y especuladores que «hacían el agosto» en eBay o StockX, revendiendo las tarjetas gráficas por más del doble.

Toda esta problemática la tratábamos en nuestra entrada relativa a la escasez de las tarjetas gráficas.

En todo este tumulto, NVIDIA compraba 2 empresas tecnológicas punteras: Mellanox (creadora de las DPU) y Arm, un gigante de la informática.

Como la historia de NVIDIA no para ni un segundo, iremos actualizando esta entrada conforme se vayan sucediendo las siguientes generaciones de tarjetas gráficas. Esperamos que os haya sido de ayuda, y si tenéis alguna pregunta, dejadla abajo para responderla rápidamente.

Te recomendamos las mejores tarjetas gráficas del mercado

¿Qué os parece la historia de NVIDIA?