Todos conocemos la memoria RAM de nuestro ordenador, pero hay un concepto igual de importante, la VRAM de una tarjeta gráfica. Vamos a repasar qué es, cómo funciona, qué tipos hay y por qué es importante.

Índice de contenidos

¿Qué es la VRAM?

VRAM son las siglas de Video RAM, es decir, Video Random Access Memory. El nombre ya nos deja bastante claro que tendrá un funcionamiento parecido a la RAM principal de nuestro ordenador, pero su uso es muy distinto.

La VRAM de una tarjeta gráfica se usa principalmente para almacenar temporalmente texturas gráficas, modelos 3D, y todo tipo de información necesaria para renderizar un fotograma, como podría ser la información de shaders o de iluminación. En resumen, es de donde la GPU obtendrá todo lo que necesita para renderizar cada fotograma que verás por pantalla, y por eso es muy importante en juegos, donde se estarán usando siempre miles y miles de texturas de alta resolución.

La VRAM de una tarjeta gráfica se usa principalmente para almacenar temporalmente texturas gráficas, modelos 3D, y todo tipo de información necesaria para renderizar un fotograma, como podría ser la información de shaders o de iluminación. En resumen, es de donde la GPU obtendrá todo lo que necesita para renderizar cada fotograma que verás por pantalla, y por eso es muy importante en juegos, donde se estarán usando siempre miles y miles de texturas de alta resolución.

Grandes diferencias entre RAM y VRAM: memorias dual-ported

Una de las características más importantes de la VRAM de una tarjeta gráfica es que es de tipo dual-ported. Esto significa que los chips de memoria pueden admitir que se le hagan lecturas y escrituras al mismo tiempo, mientras que en la RAM principal solo permiten un tipo de acceso simultáneo.

Para que os hagáis una idea, esto es lo que permite que el framebuffer de la VRAM, de donde se indica cómo debe ser cada uno de los píxeles que saldrán por la pantalla, sea leído para sacar la imagen por el monitor a la vez que se actualiza otro framebuffer con los datos del siguiente fotograma. Si la VRAM no fuese dual-ported, habría que esperar a que se imprimiese cada fotograma para empezar a generar el siguiente.

A lo largo del artículo seguiremos viendo diferencias entre las RAM y VRAM, particularmente en las DDR usadas en las primeras y GDDR usadas en las segundas.

¿Por qué las tarjetas gráficas profesionales tienen tanta VRAM?

Si te fijas en las tarjetas gráficas que podemos encontrar en el mercado actualmente, verás que se parte de los 4GB para gráficas de gama baja, y se llega a los 10-16GB de los modelos de gama alta (como la RTX 3080 o RX 6800 XT), o 24GB de la RTX 3090. Pero las tarjetas profesionales siempre están un paso más allá, como la recién lanzada NVIDIA RTX A6000 48GB. Si antes os hablábamos de la VRAM como algo necesario para texturas de juegos, ¿cómo va a importar tanto la memoria en una GPU profesional?

Si te fijas en las tarjetas gráficas que podemos encontrar en el mercado actualmente, verás que se parte de los 4GB para gráficas de gama baja, y se llega a los 10-16GB de los modelos de gama alta (como la RTX 3080 o RX 6800 XT), o 24GB de la RTX 3090. Pero las tarjetas profesionales siempre están un paso más allá, como la recién lanzada NVIDIA RTX A6000 48GB. Si antes os hablábamos de la VRAM como algo necesario para texturas de juegos, ¿cómo va a importar tanto la memoria en una GPU profesional?

Básicamente, se debe a la naturaleza del uso de las tarjetas gráficas profesionales. Por ejemplo, una de sus aplicaciones más comunes es la de realizar tareas de computación e inteligencia artificial, de tal forma que más que para mostrar fotogramas en pantalla, las GPU se usan para ejecutar millones de cálculos, como podrían ser operaciones con matrices con números de coma flotante, y muchas veces dichos cálculos usan un conjunto de datos de entrada inmenso que requiere una VRAM especialmente grande.

Básicamente, se debe a la naturaleza del uso de las tarjetas gráficas profesionales. Por ejemplo, una de sus aplicaciones más comunes es la de realizar tareas de computación e inteligencia artificial, de tal forma que más que para mostrar fotogramas en pantalla, las GPU se usan para ejecutar millones de cálculos, como podrían ser operaciones con matrices con números de coma flotante, y muchas veces dichos cálculos usan un conjunto de datos de entrada inmenso que requiere una VRAM especialmente grande.

Por ejemplo, pensad en una compañía que usa varias GPU de máximo rendimiento para procesar a la vez toda la información de sus millones de clientes, aplicándoles algún algoritmo de inteligencia artificial. El Big Data, en definitiva, es una de las mayores aplicaciones de las GPU profesionales y requiere una inmensa cantidad de datos.

Tipos de VRAM: GDDR y HBM

Memorias GDDR (GDDR5, GDDR5X, GDDR6, GDDR6X)

Las memorias VRAM más usadas en la actualidad son las de tipo GDDR, esto es, Graphics DDR o Graphics Double Data Rate. Aquí, ocurre algo parecido con la distinción entre RAM y VRAM, pues son memorias similares a las DDR que encontramos en la RAM principal de un ordenador, pero con modificaciones importantes que le dan un ámbito de uso totalmente distinto.

La generación de GDDR más usada a lo largo del tiempo fue GDDR5, cuyo diseño estaba basado en DDR3, y que se estuvo usando durante buena parte de la última década, incluyendo su variante GDDR5X.

La generación de GDDR más usada a lo largo del tiempo fue GDDR5, cuyo diseño estaba basado en DDR3, y que se estuvo usando durante buena parte de la última década, incluyendo su variante GDDR5X.

En la actualidad, las últimas tarjetas gráficas lanzadas han estado usando memorias GDDR6, que vienen a aumentar aún más su frecuencia efectiva respecto a GDDR5 (con un máximo de 8 Gbps) o GDDR5X (donde pudimos llegar a ver modelos de 11 Gbps). Ahora, GDDR6 llega a frecuencias de 14Gbps, que en su variante GDDR6X (usada únicamente en las nuevas gráficas de NVIDIA, por ahora) llega a los 19.5 Gbps de frecuencia.

¿Por qué no se usan memorias GDDR5 o GDDR6 en las CPUs, y sí como VRAM? ¿No es GDDR superior a DDR?

Pongamos tres ideas en común: las frecuencias efectivas de unas memorias GDDR6 son muy superiores a DDR4, su ancho de banda también es mucho mayor, y las CPU dependen cada vez más de la velocidad de la RAM. Entonces, ¿por qué no se están usando memorias de tipo GDDR6 o similar en los procesadores?

La verdad es que, precisamente, las memorias GDDR nacieron para enfocarse en las necesidades que tienen las tarjetas gráficas, y no estar limitados a lo que necesita una CPU. Y es que las velocidades de las memorias GDDR se consiguen a expensas de un gran aumento en la latencia. Es decir, que el retardo que ocurre entre que se pide un dato y se empieza a transferir es mayor, pero una vez empieza la transferencia esta es mucho más rápida. Esto es lo deseable en una GPU, donde tenemos grandes texturas que transferir, pero la naturaleza de funcionamiento de una CPU hace mucho más común que se transfiera una gran cantidad de datos muy pequeños, lo que le da gran importancia a la latencia.

Además, las memorias GDDR están pensadas para usarse como chips soldados muy próximos al chip de la tarjeta gráfica, y en ningún caso en forma de módulos de memoria que están bastante más separados de la CPU. A esto todavía hay más que sumarle: tened en cuenta que el consumo de unas memorias GDDR6 es mucho más grande que el de DDR4, y precisamente estas requieren funcionar con thermal pads que las unan a los grandes disipadores de las gráficas, mientras que en una RAM normal un pequeño disipador metálico podría no ser ni siquiera necesario.

Además, las memorias GDDR están pensadas para usarse como chips soldados muy próximos al chip de la tarjeta gráfica, y en ningún caso en forma de módulos de memoria que están bastante más separados de la CPU. A esto todavía hay más que sumarle: tened en cuenta que el consumo de unas memorias GDDR6 es mucho más grande que el de DDR4, y precisamente estas requieren funcionar con thermal pads que las unan a los grandes disipadores de las gráficas, mientras que en una RAM normal un pequeño disipador metálico podría no ser ni siquiera necesario.

Si vamos todavía más allá, recordemos que actualmente los controladores de memoria de las CPU están bastante limitados para conseguir funcionar con altas frecuencias, así que ya no solo estaremos limitados por la distancia física entre el chip de la CPU y las memorias, sino que su propio IMC (Integrated Memory Controller) estará ampliamente limitado.

En resumen, hay una innumerable cantidad de motivos por los que no veremos una VRAM GDDR6 como RAM principal de un ordenador…

Ahora vamos a ver otro tipo de memorias que nos da muchísimo juego por toda la historia que hay al respecto, HBM.

Memorias HBM, la gran revolución que no triunfó en gaming

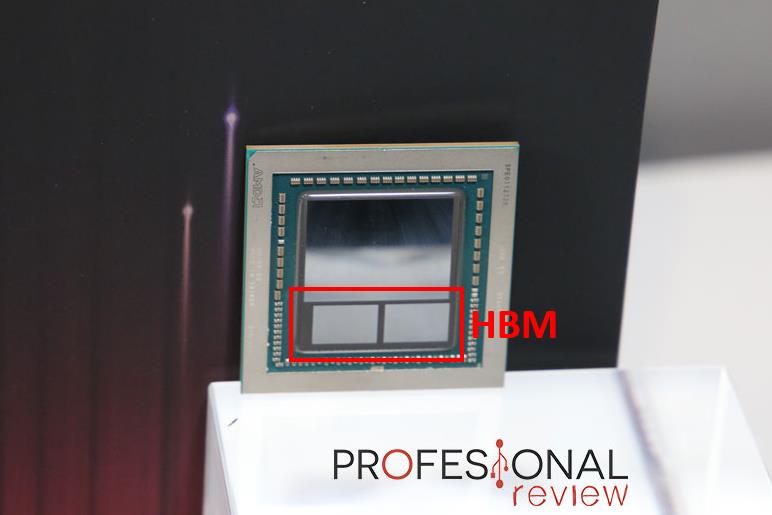

Las memorias de tipo HBM son la gran alternativa a las GDDR5, GDDR6 y demás. A primera vista, la gran diferencia que veremos con las demás es el hecho de que se colocan en el propio chip, y no fuera.

Las memorias de tipo HBM son la gran alternativa a las GDDR5, GDDR6 y demás. A primera vista, la gran diferencia que veremos con las demás es el hecho de que se colocan en el propio chip, y no fuera.

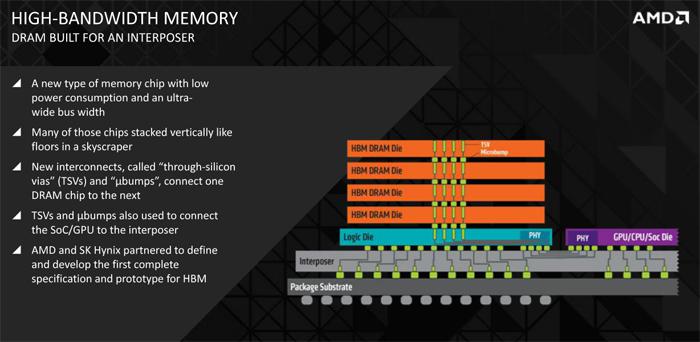

Además de esto, también nos sorprenderá ver que su fabricación se basa en apilar varias memorias en distintos pisos, para así aumentar la densidad.

Además de esto, también nos sorprenderá ver que su fabricación se basa en apilar varias memorias en distintos pisos, para así aumentar la densidad.

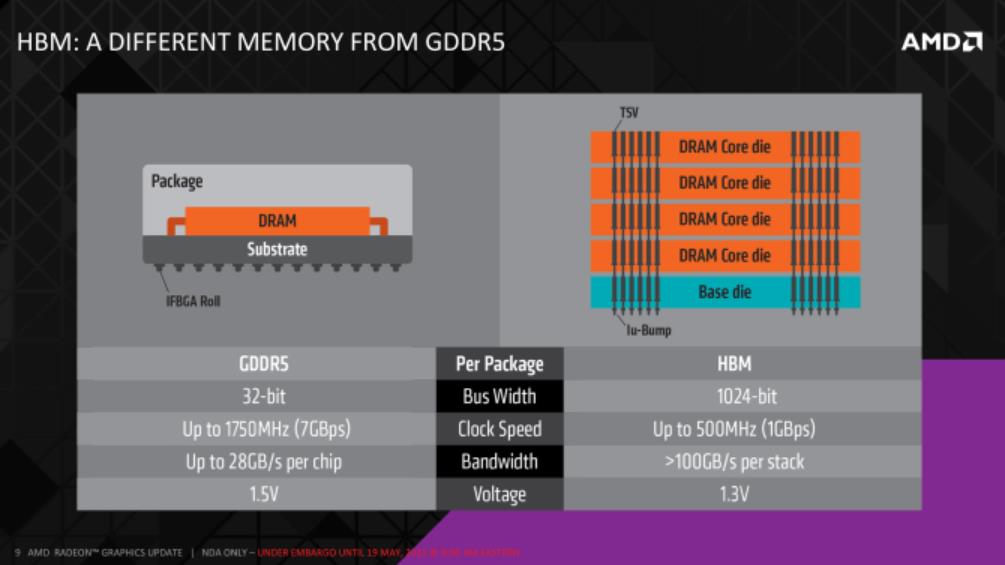

El nacimiento de HBM se produjo básicamente por la gran necesidad de mejorar el ancho de banda de las memorias de las tarjetas gráficas, pero sin aumentar su consumo energético en exceso. En el momento de su desarrollo imperaba GDDR5, y la mejora de su ancho de banda implicaba un aumento desproporcionado en el consumo.

En la implementación de HBM, un componente fundamental es el interposer o interceptor, que en esencia es básicamente un chip que, en vez de contener lógica, únicamente tiene capas en las que se realizan las interconexiones necesarias entre la GPU y el sistema de memoria HBM. Así es como se consigue tener a las memorias dentro del propio chip, con la máxima proximidad posible al propio chip gráfico. Esta cercanía espacial nos da una serie de ventajas muy importantes:

En la implementación de HBM, un componente fundamental es el interposer o interceptor, que en esencia es básicamente un chip que, en vez de contener lógica, únicamente tiene capas en las que se realizan las interconexiones necesarias entre la GPU y el sistema de memoria HBM. Así es como se consigue tener a las memorias dentro del propio chip, con la máxima proximidad posible al propio chip gráfico. Esta cercanía espacial nos da una serie de ventajas muy importantes:

- Simplifica bastante la comunicación.

- Permite que la señal llegue con mayor integridad a la gráfica, ya que con tan poca distancia apenas habrá pérdidas de señal, que son un factor muy importante a tener en cuenta cuando hablamos del alto rendimiento.

- Permite anchos de bus extremadamente grandes. Por ejemplo: mientras en una Vega 64 tenemos un bus de 2048 bits, una RTX 3090 tiene 384 bits. Y es que con GDDR tenemos que crear las trazas de dicho bus en el PCB, nada que ver con la comunicación tan directa que permite una memoria HBM.

¿Por qué el uso de memorias HBM no ha trascendido?

Hasta ahora todo parece muy bonito sobre HBM, ¿no? Pues, desgraciadamente, esta tecnología tiene una serie de limitaciones importantes que han hecho que no haya tenido éxito en el mercado de las GPU domésticas. Tanto AMD como NVIDIA las siguen usando en modelos profesionales donde el ancho de banda de memorias es aún más fundamental, pero la primera abandonó este tipo de memorias con sus primeras gráficas Navi (RX 5000) lanzadas en 2019, después del poco éxito de Vega. NVIDIA no llegó a lanzar ninguna gráfica de consumidor con memorias HBM.

El gran problema de HBM ha estado siempre en su inmenso coste de fabricación. Si citamos un análisis al respecto de GamersNexus, la misma capacidad de HBM2 costaba básicamente el triple que GDDR5 hace unos 3 años. El coste de los propios chips apilados y del interceptor se dispara, provocando que la VRAM represente la mayor parte del coste de fabricación de la gráfica. Si a esto le sumamos la mayor posibilidad de tener un chip defectuoso (con las gráficas Vega de referencia se regalaba uno para coleccionarlo) entonces tenemos la clara conclusión de que los márgenes de beneficio de AMD sangraban con HBM2.

Todo depende también de la dependencia de la velocidad de memorias que tenga cada arquitectura gráfica. Vega fue un buen ejemplo de ello, pues overclockear la memoria era simplemente más provechoso que hacérselo al núcleo en sí.

¿Qué VRAM tienen las tarjetas gráficas integradas?

En el artículo hemos hablado en todo momento sobre tarjetas gráficas dedicadas, pero… ¿qué ocurre en el caso de los gráficos integrados de las CPU? En este caso, habrá básicamente dos implementaciones posibles:

- Hay un chip de VRAM dedicada aparte dentro o fuera del chip al que acceden los gráficos integrados.

- La CPU y la iGPU comparten la misma memoria RAM.

Este segundo caso es sin duda el más común, y por el que apuestan casi todas las CPUs con gráficos integrados de Intel y APU de AMD. En particular, estas últimas reservan una cantidad de memoria concreta para la gráfica integrada, por ejemplo en un procesador Ryzen 2400G tendremos 2GB reservados para la gráfica por defecto, aunque lo podemos cambiar en la BIOS.

Destacar que este tipo de procesadores son una buena demostración de la importancia de la VRAM, pues aún con la relativamente baja potencia de estas gráficas se pueden observar grandes incrementos de rendimiento si mejoramos las frecuencias de la RAM.

Esperamos que este artículo te haya ayudado a conocer mejor la importancia de la VRAM en una tarjeta gráfica. ¡Gracias por leernos!