Tras la inminente salida de las nuevas tarjetas gráficas Nvidia RTX. Hemos querido elaborar un artículo sobre qué es la rasterización y cual es su diferencia con el Ray Tracing. ¿Preparado para conocer todo lo que necesitas saber sobre esta tecnología? ¡Comenzamos!

Qué es la rasterización y diferencias Ray Tracing

Los gráficos de PC en tiempo real han utilizado durante mucho tiempo una técnica llamada «rasterización» para mostrar objetos tridimensionales en una pantalla bidimensional. Es una técnica rápida y los resultados se han vuelto muy buenos a lo largo de los últimos años, aunque no es tan bueno como lo que puede hacer el trazado de rayos.

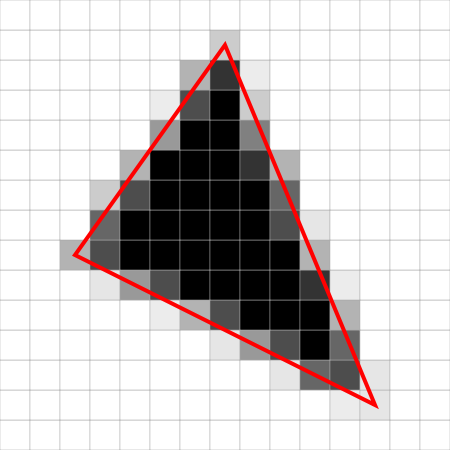

Con la técnica de la rasterización, los objetos que ves en la pantalla se crean a partir de una malla de triángulos virtuales, o polígonos, los cuales crean modelos tridimensionales de objetos. En esta malla virtual, las esquinas de cada triángulo, conocidas como vértices, se cruzan con los vértices de otros triángulos de diferentes tamaños y formas. Debido a esto, se asocia mucha información con cada vértice, incluida su posición en el espacio, así como información sobre el color, la textura y su «normal», que se utiliza para determinar la forma en que se enfrenta la superficie de un objeto.

Los ordenadores convierten luego los triángulos de los modelos 3D en píxeles, o puntos en una pantalla 2D. A cada píxel se le puede asignar un valor de color inicial a partir de los datos almacenados en los vértices del triángulo. El procesamiento de píxeles adicional o «sombreado», que incluye cambiar el color del píxel en función de cómo las luces en la escena golpean el píxel, y la aplicación de una o más texturas al píxel, se combinan para generar el color final aplicado a un píxel.

Os resumimos las mejores guías de hardware que deberían interesarte:

Esto es una tarea computacionalmente intensiva, ya que puede haber millones de polígonos utilizados para todos los modelos de objetos en una escena, y aproximadamente 8 millones de píxeles en una pantalla 4K. A todo esto hay que sumar que cada imagen que se muestra en una pantalla suele actualizarse de 30 a 90 veces por segundo. Además, los búferes de memoria, el espacio temporal reservado para acelerar las cosas, se utilizan para renderizar los fotogramas por adelantado antes de que se muestren en la pantalla.

También se usa una profundidad o «z-buffer» para almacenar información de profundidad de píxeles para asegurar que los objetos frontales en la ubicación x-y de la pantalla de un píxel se muestran en pantalla, y los objetos detrás del objeto más frontal permanecen ocultos. Esta es la razón por la cual los juegos de computadora modernos y gráficamente ricos se basan en poderosas GPUs, las cuales son capaces de hacer muchos millones de cálculos cada segundo.

El Ray Tracing funciona de una forma totalmente diferente. En el mundo real, los objetos 3D que vemos están iluminados por fuentes de luz, y los fotones que forman la luz pueden rebotar de un objeto a otro antes de llegar a los ojos del espectador. Además, la luz puede ser bloqueada por algunos objetos, creando sombras, o la luz puede reflejarse de un objeto a otro, como cuando vemos las imágenes de un objeto reflejadas en la superficie de otro. También tenemos las refracciones, que causan un cambio en la velocidad y la dirección de la luz a medida que pasa a través de objetos transparentes o semitransparentes, como vidrio o agua.

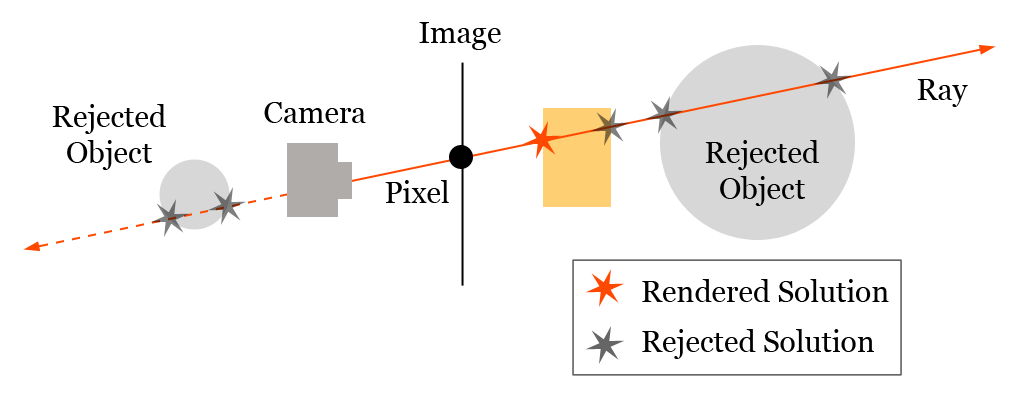

El Ray Tracing reproduce esos efectos, se trata de una técnica que fue descrita por primera vez por Arthur Appel de IBM, en 1969. Esta técnica traza el camino de una luz que atraviesa cada píxel en una superficie de visualización 2D y lo convierte en un modelo 3D de la escena. El próximo avance importante se produjo una década después en un documento de 1979 titulado «Un modelo de iluminación mejorado para pantalla sombreada», Turner Whitted, ahora miembro de Nvidia Research, mostró cómo capturar la reflexión, las sombras y la refracción con la técnica del Ray Tracing.

Con la técnica de Whitted, cuando un rayo encuentra un objeto en la escena, el color y la información de iluminación en el punto de impacto en la superficie del objeto contribuyen al color del píxel y al nivel de iluminación. Si el rayo rebota o viaja a través de las superficies de diferentes objetos antes de llegar a la fuente de luz, el color y la información de iluminación de todos esos objetos pueden contribuir al color final del píxel.

Otro par de documentos en la década de 1980 establecieron el resto de la base intelectual para la revolución de gráficos por computadora, que volcó la forma en que se hacen las películas. En 1984, Robert Cook, Thomas Porter y Loren Carpenter, de Lucasfilm, detallaron cómo el Ray Tracing podría incorporar varias técnicas cinematográficas comunes como el desenfoque de movimiento, la profundidad de campo, penumbras, translucidez y reflejos borrosos que, hasta entonces, solo podían crearse con cámaras. Dos años más tarde, el trabajo del profesor de CalTech Jim Kajiya, «The Rendering Equation», terminó el trabajo de mapeo de la forma en que se generaron los gráficos por computadora a la física para representar mejor la forma en que la luz se dispersa en una escena.

Al combinar toda esta investigación con las GPU modernas, los resultados que se obtienen son imágenes generadas por ordenador que capturan sombras, reflejos y refracciones de maneras que pueden ser indistinguibles de fotografías o videos del mundo real. Ese realismo es por lo que el Ray Tracing ha llegado a conquistar el cine moderno. La siguiente imagen generada por Enrico Cerica usando OctaneRender, muestra una distorsión de trazos de vidrio en la lámpara, iluminación difusa en la ventana y vidrio esmerilado en la linterna en el piso reflejado en la imagen del marco.

El Ray Tracing es una técnica extremadamente demandante de potencia, es por eso que los cineastas dependen de un gran número de servidores o de granjas para crear sus escenas en un proceso que puede tomar días, incluso semanas, para generar efectos especiales complejos. Sin duda, muchos factores contribuyen a la calidad global de los gráficos y al rendimiento del trazado de rayos. De hecho, debido a que el trazado de rayos es tan computacionalmente intenso, a menudo se utiliza para representar aquellas áreas u objetos en una escena que se benefician más de la calidad visual y el realismo de la técnica, mientras que el resto de la escena se procesa usando rasterización.

¿Qué te ha parecido nuestro artículo sobre que es la rasterización? ¿Os ha parecido interesante? ¡Esperamso vuestros comentarios!