JEDEC actualizó el estándar HBM2 a 3.2 Gbps, y Samsung fue la primera en ofrecer sus memorias Flashbolt, que hacían uso de HBM2E. SK Hynix, Rambus y Micron también se han sumado al desarrollo y uso de este tipo de memoria que parece reemplazar a HBM2.

Es, incluso, difícil ver productos de consumo que vengan con memoria HBM2, por lo que esta tecnología no nos afecta mucho, ¿verdad? No es así, y es que el apilado ha venido para quedarse, pero está evolucionando a pasos agigantados. El interposer no lo pone fácil, pero HBM2E promete lo extraordinario.

Índice de contenidos

HBM2E: qué es y cómo funciona

Las siglas HBM significan High Bandwith Memory, mientras que HBM2 sería la segunda generación de la memoria HBM. Sin embargo, ¿qué es HBM2E?

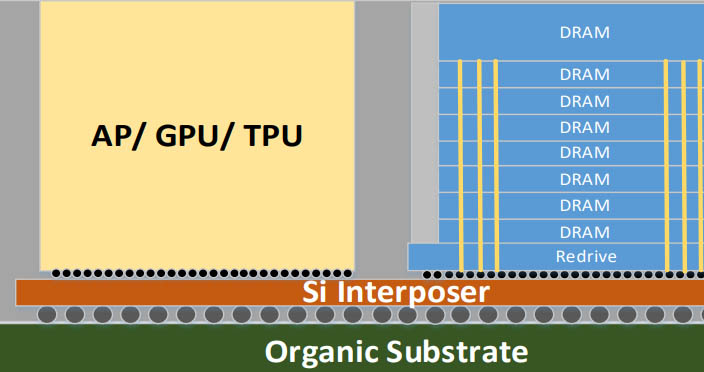

HBM2E es una memoria DRAM con una integración 3D (apilado) de 4 u 8 capas de memoria en un único paquete. Se añade una capa adicional en la base de la «torre de memorias» que actúa como host ASIC y añade otras funciones a la memoria HBM2E.

Esta memoria está soldada a un interposer de silicio que direcciona todas las señales de la interfaz en pequeñas señales al host ASIC. Como veis, la estructura 3D queda de la siguiente manera:

Lo característico de HBM era que las memorias se apilaban unas encimas de las otras, siendo interconectadas. Esto permitía ahorrar espacio en la PCB, pero ofrecía 2 problemas:

- El interposer es un componente muy caro.

- El proceso de fabricación es más difícil.

Las memorias HBM2E también son conocidas como KGSD (Known Good Stacked Die), y las empresas tienen que integrar en dicha memoria su propio host ASIC (conocido como SoC) como un sistema en paquete.

Decir que la memoria HBM es la DRAM más rápida del mundo y está diseñada para soluciones que requieren el máximo ancho de banda posible. Por este motivo, la memoria HBM2E encaja perfectamente en las necesidades del HPC (computación de alto rendimiento), inteligencia artificial y otras aplicaciones en las que GDDR6 o GDDR6X no permite el mismo rendimiento.

El objetivo que se persigue con esa integración tan apretada es obtener una eficiencia energética importante en todo el subsistema (tanto en el SoC, como en la DRAM). Las restricciones de enrutamiento de señal de los PCBs limitan el número de líneas de datos por SoC (aprox. 384 líneas). La única forma de lograr un mayor de ancho de banda es aumentar la velocidad de datos por pin.

Gracias a ello, el beneficio es que todo el tráfico de la memoria reside completamente dentro del SiP. Con el uso de estas tecnologías avanzadas de empaquetado, como son los interposers, se habilita que el bus de datos sea mucho más amplio y que la velocidad de datos por pines sea menor.

En el desarrollo de la memoria HBM, AMD ha tenido una importancia muy grande porque ha sido uno de los co-desarrolladores. junto con Samsung. Joe Macri, vicepresidente y director de la división de computación y gráficos de AMD, dijo lo siguiente:

Cuando creamos HBM2, queríamos expandir al mercado sus bondades, pero agregar 2 dimensiones: la capacidad y más ancho de banda.

Todavía tiene 1.024 bits de ancho, pero se ha duplicado la frecuencia a 2 gigacanales y se ha añadido el ECC (código de corrección de errores) para los centros de datos, IA y Machine language.

Los únicos bits que se agregaron a la interfaz fueron para aumentar la direccionabilidad, pero HBM2E tiene la misma interfaz, solo que se ejecuta en una interfaz más altas de 3.2 gigatransferencias por segundo.

¿Por qué es necesaria esta memoria?

La memoria HBM2E encuentra sentido en los centros de datos porque, en estos entornos, se ejecutan cargas de trabajo de gráficos muy altas que hacen uso de Inteligencia Artificial y Machine Learning.

Pensad que en la cantidad de datos que se analizan (hablamos de terabytes), por lo que la inteligencia artificial entra como un protagonista muy importante. Las empresas tecnológicas se beneficiarán de HBM2E porque:

- Su velocidad es mucho más rápida.

- Consume mucho menos energía.

- Su capacidad aumenta un 50%, por lo que se le puede cargar más trabajo.

Actualmente, la IA requiere mucha memoria para ofrecer un rendimiento TOP, y es que pensad que las aplicaciones requieren compresión y descompresión de datos. Por ello, los FPGA que están basados en HBM pueden trabajar eficientemente y mover datos más grandes.

La memoria HBM2E se limita a usarse en GPUs y en dispositivos de red de gama alta.

HBM2E vs HBM2

El cambio de HBM2 a 2E es una actualización de velocidades y alimentaciones, según Samsung. O séase, que no es la revolución que algunos se piensan porque hay que tener en cuenta que HBM2 tiene un tope máximo de capacidad que está limitada a la memoria del coprocesador.

Por tanto, prefieren usar la palabra «evolución» y no «revolución», siendo HBM2E una extensión de HBM2. Sin embargo, ¿en qué mejora la una a la otra?

- Más rápida.

- Más bits de dirección.

- 4 veces más grande.

- Más capacidad.

En el caso de HBM2E, utiliza 4 pilas con un procesador que tiene una interfaz de 4096 bits, como si fuese una GPU o FPGA. De este modo, se puede conseguir 64GB con un ancho de banda de hasta 1.64 TB/s.

Actualmente, las tarjetas gráficas profesionales de NVIDIA y AMD usan memoria HBM2, haciendo uso más de 30 GB en cada una. En escritorio, hemos visto HBM2 en las Radeon R9 Fury X, Vega 56 y Vega 64, pero su rendimiento fue malo porque la arquitectura es un aspecto clave en videojuegos.

¿Por qué no vemos HBM2, ni HBM2E en consumo?

Si nos vamos a consumo, son 2 las áreas que requieren mucha memoria VRAM: los programas profesionales y los videojuegos. NVIDIA y AMD lanzan la misma arquitectura para estas 2 áreas, y esto es un punto clave para su viabilidad.

Justo antes hemos comentado que AMD lanzó varias GPUs con memoria HBM y no dieron un gran rendimiento por la importancia que tiene la arquitectura en este aspecto. Principalmente, no vemos este tipo de memoria porque la relación coste-rendimiento del GDDR6 sigue siendo mucho más interesante, y ahora más con el GDDR6X en el mercado.

Aquí es dónde entra el principal problema de la HBM DRAM: fabricar paquetes 2.5D es caro y la disponibilidad es limitada. Además, el precio final influye en que el mercado todavía no ha crecido lo suficiente, pero si la demanda sube, la producción será más barata.

En tarjetas gráficas, vemos las Tesla, algunas Quadro o Radeon MI que equipan este tipo de memoria, pero, ¿habéis visto el precio que tienen dichas GPUs? Muy alto. Por tanto, para las necesidades gaming que hay en esta nueva década de 2020, la memoria GDDR cumple su cometido.

Eso sí, hay que decir que, si el precio de HBM2E se reduce lo suficiente como para hacer viable su presencia en tarjetas gráficas gaming, tendremos un nuevo sucesor de GDDR.

Te recomendamos las mejores tarjetas gráficas del mercado

Esperamos que os haya sido útil esta información. Si tenéis alguna duda, podéis comentar abajo para que os podamos ayudar. ¿Qué opináis sobre el futuro de HBM2?