AMD Instinct MI250 está recibiendo una importante mejora de rendimiento en inteligencia artificial con PyTorch 2.0 y ROCm 5.4.

AMD Instinct MI250 mejora su rendimiento en la IA

La tarjeta aceleradora de AMD se estaría acercando al desempeño de las GPUs de Nvidia en términos de entrenamiento LLM.

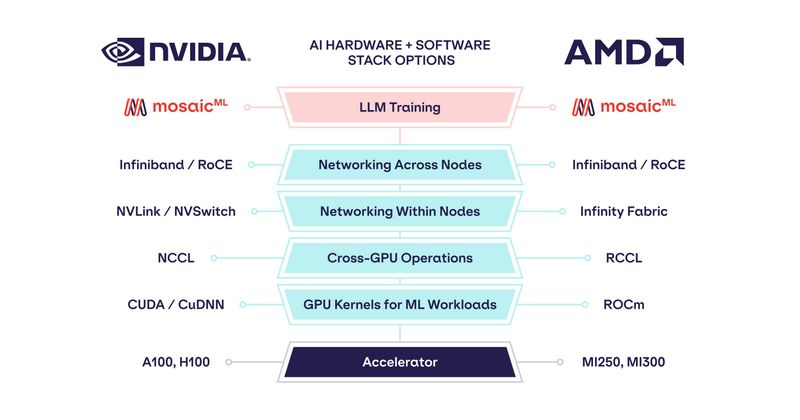

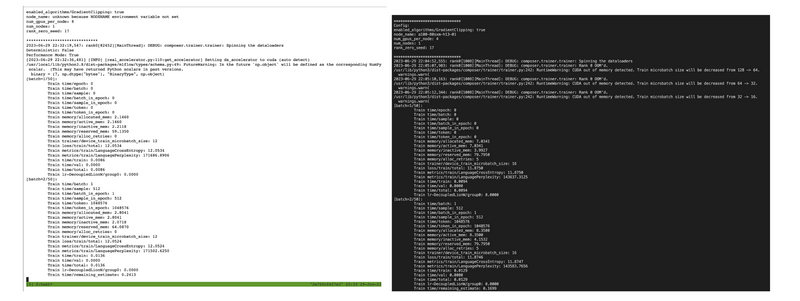

El blog oficial de MosaicML está mostrando como PyTorch 2.0 y ROCM 5.4 están mejorando el rendimiento de las GPUs AMD Instinct MI250 para centros de datos de AMD, unas mejoras que llegan sin necesidad de hacer cambios en el código. Los últimos lanzamientos han permitido a MosaicML sacar un mayor provecho de las GPUs AMD Instinct con el uso de su LLM Foundry Stack.

El proveedor de software MosaicML ofrece soporte mejorado para el entrenamiento ML y LLM para las soluciones de Nvidia y AMD que admiten precisión de 16 bits (FP16 / BF16).

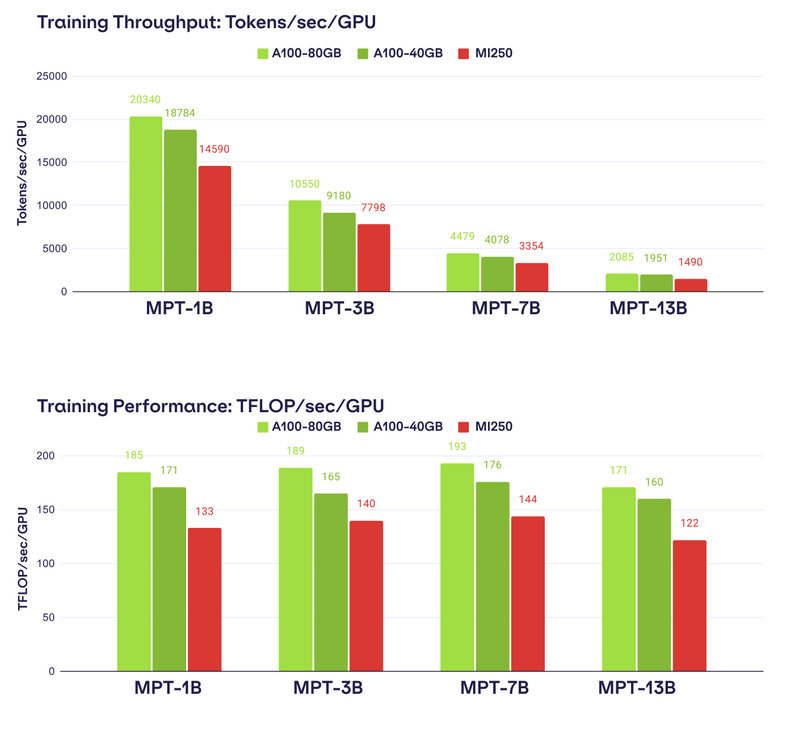

Por supuesto, se realizaron pruebas de rendimiento para comparar el desempeño del Instinct MI250 frente a las dos variantes de Nvidia A100, que cuentan con 40 GB y 80 GB. Por lo que podemos observar, el MI250 pudo alcanzar un 80% del rendimiento de la A100 de 40 GB y un 73% del rendimiento de la variante de 80 GB. Aquí hay que tener en cuenta que el MI250 puede escalar en hasta 4 aceleradoras, mientras que el A100 puede escalar con hasta 8, por lo que Nvidia tenía ventaja.

Debemos tener en cuenta el MI250 es más rápida que el A100 en términos de rendimiento FP16 (sin sparsity), tiene más capacidad de memoria y mayor ancho de banda con sus 128 GB HBM2e. Por lo tanto, es una aceleradora que tiene un mayor margen de mejora.

Te recomendamos nuestra guía sobre las mejores tarjetas gráficas del mercado

AMD ya está preparando sus aceleradoras Instinct MI300, que van a estar especialmente diseñadas para la aceleración de trabajos HPC y de IA, por lo que podemos esperar un gran avance en términos de rendimiento para estas tareas. AMD ya demostró como el MI300 es capaz de gestionar un modelo LLM con 40.000 millones de parámetros en una única solución, muy superior a las pruebas vistas aquí con parámetros entre 1.000 millones y 13.000 millones.

Sabemos que el MI300 va a contar con una capacidad de 192 GB de memoria HBM3, que será importante para AMD y su objetivo de coger parte del pastel de la IA, que Nvidia posee en un 90%.