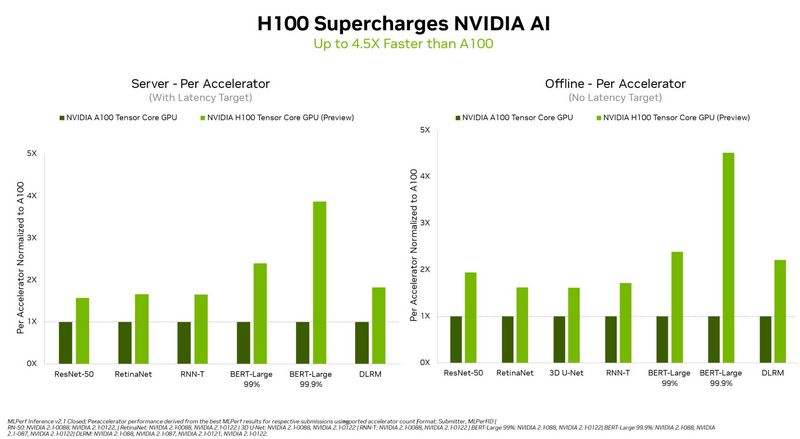

Nvidia arrasa en las pruebas de IA de MLPerf con la GPU Hopper H100. El rendimiento se multiplicaría por 4 en comparación con el A100 de generación ‘Ampere’, aportando grandes resultados en las tareas de IA.

Nvidia Hopper H100 arrasa en las pruebas de IA de MLPerf

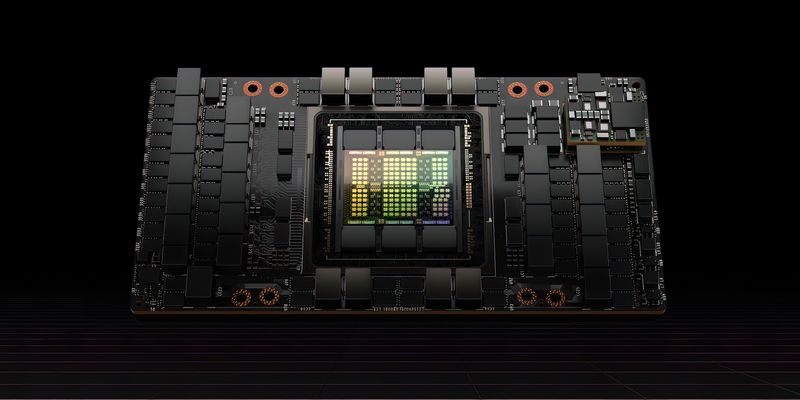

La GPU H100 ‘Hopper’ es una gráfica dedicada a servidores y centro de datos que ofrece una gran potencia de cálculo, que además está diseñada para operaciones de inteligencia artificial. No es sorpresa que el rendimiento en tareas de IA sea sorprendente, como lo demuestra en las pruebas de MLPerf.

La revolución de la IA de Nvidia continúa con la GPU Hopper H100 Tensor Core, que supera todas las pruebas de MLPerf y ofrece hasta 4,5 veces más rendimiento que la última generación

Escenario offline para el centro de datos y el borde (una sola GPU)

| NVIDIA H100 (INFERENCIAS/SEG) |

NVIDIA A100 (INFERENCIAS/SEG) |

JETSON AGX ORIN (MAX INFERENCIAS/CONSULTAS) |

|

|---|---|---|---|

| DLRM (Recommender) |

695,298 | 314,992 | N/A* |

| BERT (Natural Language Processing)** |

7,921 | 1,757 | 558 |

| ResNet-50 v1.5 (Image Classification) |

81,292 | 41,893 | 6164 |

| RetinaNet (Object Detection) |

960 | 592 | 60 |

| RNN-T (Speech Recognition) |

22,885 | 13,341 | 1149 |

| 3D U-Net (Medical Imaging) |

5 | 3 | 0.5 |

La gráfica H100 Hopper está demostrando su liderazgo absoluto en términos de inteligencia artificial, logrando cuadruplicar el rendimiento de A100 Ampere, que ya era muy competente para este tipo de tareas. Esto es posible gracias al motor Transformer, que hizo que el H100 destaque en el popular modelo BERT de procesamiento del lenguaje natural.

Las pruebas de MLPerf está diseñadas para cubrir distintas áreas de la IA: visión por ordenador, procesamiento del lenguaje natural, sistemas de recomendación, reconocimiento de voz, etc. Las pruebas sirven para medir el desempeño en inteligencia artificial que es utilizada en distintos campos, como la robótica o para la investigación científica.

Estas mejoras de rendimiento no significan que el A100 vaya a ser reemplazado pronto. En su comunicado, se destaca que el A100 ha logrado multiplicar su rendimiento x6 gracias a las distintas actualizaciones de Nvidia en el software de la IA. Además, Nvidia asegura que su plataforma es la única que ejecuta todas las cargas de trabajo y escenarios de inferencia de MLPerf en centros de datos y computación de borde. Pueden ver más información en el siguiente enlace.