Nvidia RTX 【 TODA LA INFORMACIÓN 】

Las tarjetas gráficas NVIDIA RTX han sido uno de los mayores avances en tecnologías gráficas de los últimos años. En este artículo te contamos todo sobre ellas, desde su primera generación las RTX 20, hasta la tercera con las gráficas RTX 40 basadas en Ampere. Os daremos también todos los detalles sobre qué tecnologías y peculiaridades hacen tan interesante a esta generación.

¡Comenzamos!

Índice de contenidos

Os resumimos las mejores guías de hardware que seguramente te interesen leer:

Ray tracing en tiempo real, la característica que hace únicas a las NVIDIA RTX

La gran característica de todas las gráficas NVIDIA RTX es sin duda el soporte para ray tracing en tiempo real acelerado por hardware. Este concepto puede sonar a chino a los usuarios menos experimentados, aunque con el paso del tiempo desde el primer lanzamiento de RTX ya se ha popularizado su uso.

El ray tracing o trazado de rayos es una técnica de iluminación usada en animación 3D, a partir de la cual podemos obtener luces, reflejos y sombras ultrarrealistas. Una forma básica de explicar cómo funciona es decir que se basa en simular miles o millones de rayos de luz que vienen desde un objeto hasta nuestro ojo (mejor dicho, hasta la cámara) hacia atrás. Es decir, se traza desde el punto de vista de la cámara o el ojo los rayos que van hacia los objetos, y luego se calculan las sombras, reflexiones e iluminación en base a las distintas fuentes de luz que hay en la escena.

Si no has entendido el concepto, no te preocupes, ya que comprender la importancia del ray tracing es súper sencillo: básicamente, lo más probalbe es que toda animación 3D ultrarrealista que no sea de un videojuego use esta técnica. Por ejemplo, si piensas en los efectos especiales de una película, o en un objeto renderizado en 3D, el ray tracing es uno de los grandes responsables de que se vea como real.

Pues bien, si el ray tracing ya era una tecnología que existía y se llevaba usando durante décadas, ¿dónde está la novedad de NVIDIA RTX? Muy sencillo: el coste computacional del trazado de rayos es inmenso, hacer todas las simulaciones necesarias requiere muchísimo tiempo de renderizado que no se puede satisfacer en un juego, donde la renderización tiene que ser lo suficientemente rápida para mostrar los fotogramas en tiempo real y a una tasa de FPS razonable. Como alternativa, todos los juegos empleaban técnicas de rasterización para este propósito.

Con RTX, NVIDIA consigue traer el ray tracing en tiempo real a los juegos por primera vez. Básicamente, no sustituye por completo a la rasterización, sino que es un añadido «híbrido» a esta técnica con el que se consigue emplear el trazado de rayos para mejorar la iluminación, sombras y reflejos sin que el impacto en el rendimiento sea tan extremo. A nivel de software, el ray tracing de NVIDIA no es más que una implementación de Microsoft DXR (DirectX Ray Tracing), anunciado por primera vez en marzo de 2018. Las gráficas NVIDIA RTX se revelaron por primera vez en agosto de ese año, solo unos meses después.

Pero, para soportar DXR, no sirve con habilitar la característica ‘y ya’. Es fundamental introducir grandes cambios a nivel de hardware para mejorar el rendimiento. Dichos cambios han venido de la mano de la arquitectura Turing, usada en la primera generación de RTX. Veremos además cómo el significado de RTX no solo está en el ray tracing.

Pero antes de eso os vamos a dejar con un par de vídeos ideales para ilustrar las tremendas mejoras que se derivan del uso de ray tracing:

Arquitectura NVIDIA Turing

La arquitectura Turing fue la que introdujo todas las tecnologías de RTX. Esta no solo ofrece importantes mejoras respecto a Pascal (GTX 10), donde las modificaciones a nivel interno dejan un rendimiento de los núcleos CUDA un 50% superior, sino que introduce además dos de los mayores cambios a nivel de hardware de la historia reciente de las GPU.

Los nuevos RT Cores

Los RT Cores son un nuevo tipo de núcleo que habilita la magia del ray tracing. Cada SM (Streaming Multiprocessor) cuenta con uno de estos, que está pensado, diseñado y usado para operaciones muy específicas fundamentales en el ray tracing.

Recordad que, tal y como explicamos el ray tracing, vimos que para su funcionamiento es necesario ejecutar miles y miles de cálculos distintos para ver las distintas maneras en las que se comporta la luz en los objetos.

Pues bien, antes de la existencia de los RT Cores todos estos miles y miles de operaciones se ejecutaban como una emulación de software en el propio proceso de shading, suponiendo un lastre brutal en el rendimiento. Ahora, el shading se ejecuta libre de esta pesada carga de trabajo, que se ejecuta en los núcleos RT.

Gracias al uso de RT Cores las operaciones de ray tracing se pueden incrementar 10 veces, es decir, un 1000%, respecto a lo que antes encontraríamos en Turing.

La introducción de los Tensor Cores en las gráficas domésticas

El segundo gran cambio a nivel de hardware es la introducción, por primera vez, de tensor cores en tarjetas gráficas de gama doméstica. Realmente, se podría calificar como algo tan novedoso como los RT Cores, pero es que ya había núcleos de este otro tipo en la arquitectura Volta, revelada a finales de 2017.

Te recomendamos la lectura del por qué elegir una tarjeta gráfica Nvidia.

Los Tensor Cores son unidades de ejecución dedicadas específicamente al cálculo tensorial, tal y como su nombre indica. Con los Tensor Cores, se pueden acelerar de manera impresionante ciertas operaciones de multiplicación con matrices, dentro del contexto de este área del cálculo. Evidentemente, no vamos a entrar a fondo aquí, sino que nos vamos a quedar con que habilitan niveles de rendimiento nunca antes vistos en cuanto a inteligencia artifical en una gráfica doméstica.

Los Tensor Cores tienen el propósito específico de acelerar el entrenamiento de redes neuronales. ¿Para qué nos va a importar esto en Gaming? Pues para mucho. Sigue leyendo y descubrirás más.

Otros cambios de Turing (RTX 20) frente a Pascal (GTX 10)

Estas tarjetas gráficas se fabrican sobre el proceso a 12nm de TSMC, un avance en cuanto a densidad lógica respecto a los 16nm de TSMC y los 14nm de Samsung que usaban en la anterior generación, pero eso no quita que los chips de Turing sean mucho mayores (754mm2 respecto a los 471mm de Pascal). Esto se debe mayormente a los Tensor Core y los RT Core y su gran tamaño.

Estas tarjetas gráficas se fabrican sobre el proceso a 12nm de TSMC, un avance en cuanto a densidad lógica respecto a los 16nm de TSMC y los 14nm de Samsung que usaban en la anterior generación, pero eso no quita que los chips de Turing sean mucho mayores (754mm2 respecto a los 471mm de Pascal). Esto se debe mayormente a los Tensor Core y los RT Core y su gran tamaño.

Finalizamos destacando que Turing integró por primera vez las memorias de tipo GDDR6. Este tipo de memorias supone un gran avance en cuanto a eficiencia energética y ancho de banda, algo muy importante en estos contextos de alto rendimiento, donde inevitablemente tener una memoria más rápida provocará un fuerte impacto positivo en el desempeño de la GPU. Eso sí, no ha habido grandes cambios dentro de las cantidades de memoria: encontramos 11GB en la 2080 Ti y 24GB en la TITAN RTX, así que el modelo flagship de la gama GeForce se queda al mismo nivel (11GB de la 1080 Ti) y se duplica en la gama Titan.

Todos estos cambios han sonado muy bonitos, ¿no? Da la impresión de que hay una plataforma sólida para dar un buen desempeño en el nuevo ray tracing en tiempo real. Pero falta una parte muy importante: DLSS. Vamos a verla.

NVIDIA DLSS, el gran apoyo al ray tracing que completa a RTX

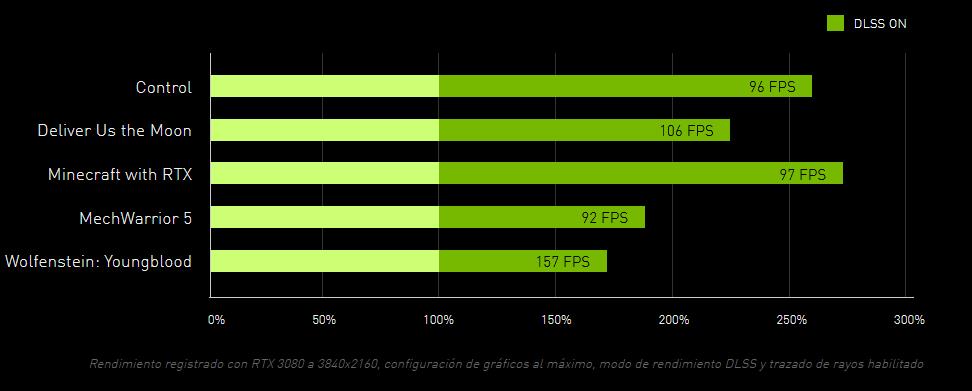

El éxito del ray tracing en juegos de NVIDIA no se explica sin tener en cuenta a Deep Learning Super Sampling (DLSS). Esta es una tecnología propietaria de la compañía que, con unas sorprendentes capacidades, consigue dar a los juegos con ray tracing un rendimiento excelente.

Si solo activamos el RT, entonces el rendimiento en muchos juegos caerá mucho, a veces hasta puntos inadmisibles, sobre todo si jugamos a altas resoluciones. Al fin y al cabo, por mucho que se use hardware dedicado y se aplique un trazado de rayos «liviano» no deja de ser una tecnología súper demandante. No obstante, si le sumamos la activación de DLSS podríamos tener tantos FPS como sin RT activado o incluso más. ¿Dónde está la magia, y qué hay que dar a cambio de esto?

Si solo activamos el RT, entonces el rendimiento en muchos juegos caerá mucho, a veces hasta puntos inadmisibles, sobre todo si jugamos a altas resoluciones. Al fin y al cabo, por mucho que se use hardware dedicado y se aplique un trazado de rayos «liviano» no deja de ser una tecnología súper demandante. No obstante, si le sumamos la activación de DLSS podríamos tener tantos FPS como sin RT activado o incluso más. ¿Dónde está la magia, y qué hay que dar a cambio de esto?

No hay un criterio único para esta denominación, pero cuando hablemos de RTX seguramente estemos tratando una configuración RT + DLSS.

Lo que consigue el DLSS es básicamente que la gráfica renderice a una resolución inferior a la que se muestra por pantalla sin perder calidad de imagen. Es decir, la gráfica puede estar trabajando a 1080p o 1440p, pero luego DLSS consigue calcular los píxeles que faltan para que por pantalla se nos muestre el juego a 4K, prácticamente como si estuviésemos jugando a resolución nativa. Para esto hace uso de los tensor cores que te introdujimos antes, ya que esos píxeles faltantes se calculan gracias al poder de la inteligencia artificial.

Los modelos del algoritmo de inteligencia artificial que emplea DLSS para que la calidad de imagen resulte indistinguible se entrenan mediante aprendizaje profundo (Deep Learning). Básicamente, para que DLSS funcione en un juego NVIDIA tiene que ejecutar millones de simulaciones en sus superordenadores, y evidentemente estos continúan mejorando. El soporte se lanza mediante diversas actualizaciones de drivers.

Los primeros de NVIDIA RTX «Turing»

Los primeros modelos lanzados bajo la nomenclatura NVIDIA RTX fueron la RTX 2080 Ti, RTX 2080 y RTX 2070, que vienen a suceder a sus predecesores homónimos (GTX 1080 Ti, GTX 1080, GTX 1070).

Los primeros modelos lanzados bajo la nomenclatura NVIDIA RTX fueron la RTX 2080 Ti, RTX 2080 y RTX 2070, que vienen a suceder a sus predecesores homónimos (GTX 1080 Ti, GTX 1080, GTX 1070).

Estos modelos fueron lanzados el 20 de agosto de 2020, y si echamos un vistazo a su rendimiento relativo en juegos sin RTX, vemos que en comparación con sus predecesoras mejoran el rendimiento en un 25%, 37% y otro 37% respectivamente, según datos de TPU.

Luego, en enero de 2019, NVIDIA lanzó el que terminaría siendo el modelo más barato con RTX de primera generación: la GeForce RTX 2060. Os dejamos con las especificaciones técnicas de todos estos modelos abajo:

| NVIDIA RTX 2080 Ti | NVIDIA RTX 2080 | NVIDIA RTX 2070 | NVIDIA RTX 2060 | |

| Arquitectura / Proceso de fabricación | NVIDIA Turing / TSMC 12 nm | |||

| Chip | TU102-300 | TU104-400 | TU106-400 | TU106-200 |

| Núcleos CUDA | 4352 | 2944 | 2304 | 1920 |

| RT Cores | 68 | 46 | 36 | 30 |

| Tensor Cores | 544 | 368 | 288 | 240 |

| SM | 68 | 46 | 36 | 30 |

| Reloj base | 1350MHz | 1515 MHz | 1410MHz | 1365MHz |

| Reloj boost | 1545MHz | 1710 MHz | 1620MHz | 1680MHz |

| Memorias | 11GB GDDR6 | 8GB GDDR6 | 8GB GDDR6 | 6GB GDDR6 |

| Frecuencia memorias (Gbps) | 14 Gbps | 14 Gbps | 14 Gbps | 14 Gbps |

| Ancho de bus | 352 bits | 256 bits | 256 bits | 192 bits |

| Cómputo FP32 | 13.45 TFLOPS | 10.07 TFLOPS | 7.46 TFLOPS | 6.45 TFLOPS |

| TGP | 250W | 215W | 175W | 160W |

| Soporte NVLink | Sí | No | ||

| Fecha de lanzamiento | Agosto de 2018 | Enero de 2019 | ||

La llegada de las RTX SUPER

La serie de gráficas RTX 20 cambió mucho en 2019, cuando NVIDIA introdujo cambios realmente importantes en su nomenclatura, lanzando las primeras gráficas con terminación «SUPER».

La serie de gráficas RTX 20 cambió mucho en 2019, cuando NVIDIA introdujo cambios realmente importantes en su nomenclatura, lanzando las primeras gráficas con terminación «SUPER».

Más que un cambio de nombre, supuso una reorganización total del mercado: la nueva RTX 2060 SUPER, aunque con menos CUDA Cores, prácticamente equivalía a una RTX 2070, y lo mismo ocurrió entre la 2070 SUPER y la 2080. A su vez, apareció la 2080 SUPER, que si bien no eclipsó ni sucedió a la 2080 Ti fue una opción mucho más atractiva para gamers, esta última fue quizás más interesante para IA.

Os dejamos el listado de especificaciones completas de las gráficas SUPER, indicando el modelo al que «más o menos» equivalen en rendimiento. No dudes en comprobar cómo se comparan las especificaciones respecto a la tabla anterior.

| NVIDIA RTX 2080 SUPER | NVIDIA RTX 2070 SUPER | NVIDIA RTX 2060 SUPER | |

| Arquitectura / Proceso de fabricación | NVIDIA Turing / TSMC 12 nm | ||

| Chip | TU104-450 | TU104-410 | TU106-410 |

| Núcleos CUDA | 3072 | 2560 | 2176 |

| RT Cores | 48 | 40 | 34 |

| Tensor Cores | 384 | 320 | 272 |

| SM | 48 | 40 | 34 |

| Reloj base | 1650MHz | 1605MHz | 1470MHz |

| Reloj boost | 1815MHz | 1770MHz | 1650MHz |

| Memorias | 8GB GDDR6 | 8GB GDDR6 | 8GB GDDR6 |

| Frecuencia memorias (Gbps) | 14 Gbps | 14 Gbps | 14 Gbps |

| Ancho de bus | 256 bits | 256 bits | 256 bits |

| Cómputo FP32 | 11.15 TFLOPS | 9.06 TFLOPS | 7.18 TFLOPS |

| TGP | 250W | 215W | 175W |

| Rendimiento situado entre | 2080 – 2080 Ti | ~2080 | ~2070 |

Turing llega también a las GTX

Finalizamos mencionando también a los modelos de NVIDIA GTX basados en Turing. Este artículo se centra en las nuevas RTX, pero es imposible entender el portfolio de gráficas de la compañía sin mencionar a sus últimos modelos GTX, que siguieron nomenclaturas que empiezan en 16. Es decir, el sucesor de una 1060 sería una 1660, y el de la 1050 una 1650.

| NVIDIA GTX 1660 Ti | NVIDIA GTX 1660 SUPER | NVIDIA GTX 1660 | NVIDIA GTX 1650 SUPER | NVIDIA GTX 1650 | |

| Arquitectura / Proceso de fabricación | NVIDIA Turing / TSMC 12 nm | ||||

| Chip | TU116-400 | TU116-300 | TU116-300 | TU116-250 | TU117-300 |

| Núcleos CUDA | 1536 | 1408 | 1408 | 1280 | 896 |

| RT Cores | 0 | 0 | 0 | 0 | 0 |

| Tensor Cores | 0 | 0 | 0 | 0 | 0 |

| SM | 24 | 22 | 22 | 20 | 14 |

| Reloj base | 1500MHz | 1530MHz | 1530MHz | 1530MHz | 1485MHz |

| Reloj boost | 1770MHz | 1785MHz | 1785MHz | 1725MHz | 1665MHz |

| Memorias | 6GB GDDR6 | 6GB GDDR6 | 4GB GDDR5 | 4GB GDDR6 | 4GB GDDR5 |

| Frecuencia memorias (Gbps) | 12 Gbps | 14 Gbps | 8 Gbps | 12 Gbps | 8 Gbps |

| Ancho de bus | 192 bits | 192 bit | 192 bits | 128 bits | 128 bits |

| Cómputo FP32 | 5.43 TFLOPS | 5.03 TFLOPS | 5.03 TFLOPS | 4.41 TFLOPS | 2.98 TFLOPS |

| TGP | 120W | 125W | 120W | 100W | 75W |

Estas gráficas, de las que os dejamos las especificaciones técnicas justo arriba, estaban enfocadas a ofrecer una apuesta actualizada en la gama media-baja, que pueda cumplir con solvencia en gaming AAA 1080p para todos aquellos que no estén interesados en el RTX, pero sí en la relación calidad-precio. Y es que estas gráficas carecen totalmente de núcleos Tensor o RT, así que no podremos ejecutar el Ray Tracing ni DLSS en ellas, algo que es entendible pues la salida de RTX no lo convirtió directamente en algo imprescindible en gaming, sino más bien en una tecnología con un gran futuro.

Como habéis podido apreciar en las especificaciones, la oferta es bastante parecida en todos los casos, pues tenemos 3 gráficas realmente similares (las de la serie 1660), donde vemos unas decisiones extrañas en cuanto a especificaciones, como por ejemplo que la 1660 Ti tenga memorias más lentas que la 1660 SUPER, que debería ser inferior. El único modelo que realmente marca una diferencia es la 1650, que es muchísimo más básica que la 1650 SUPER.

En todo caso, los modelos más interesantes de la serie 16 han sido sin duda la GTX 1660 SUPER, GTX 1660 y GTX 1650 SUPER.

NVIDIA Ampere, la segunda generación de RTX llega con la serie 3000

Después de dos años de gran éxito de las gráficas RTX, en las que la competencia de AMD no consiguió superarles con mucha claridad, tocaba el momento de renovar con una nueva arquitectura gráfica: Ampere.

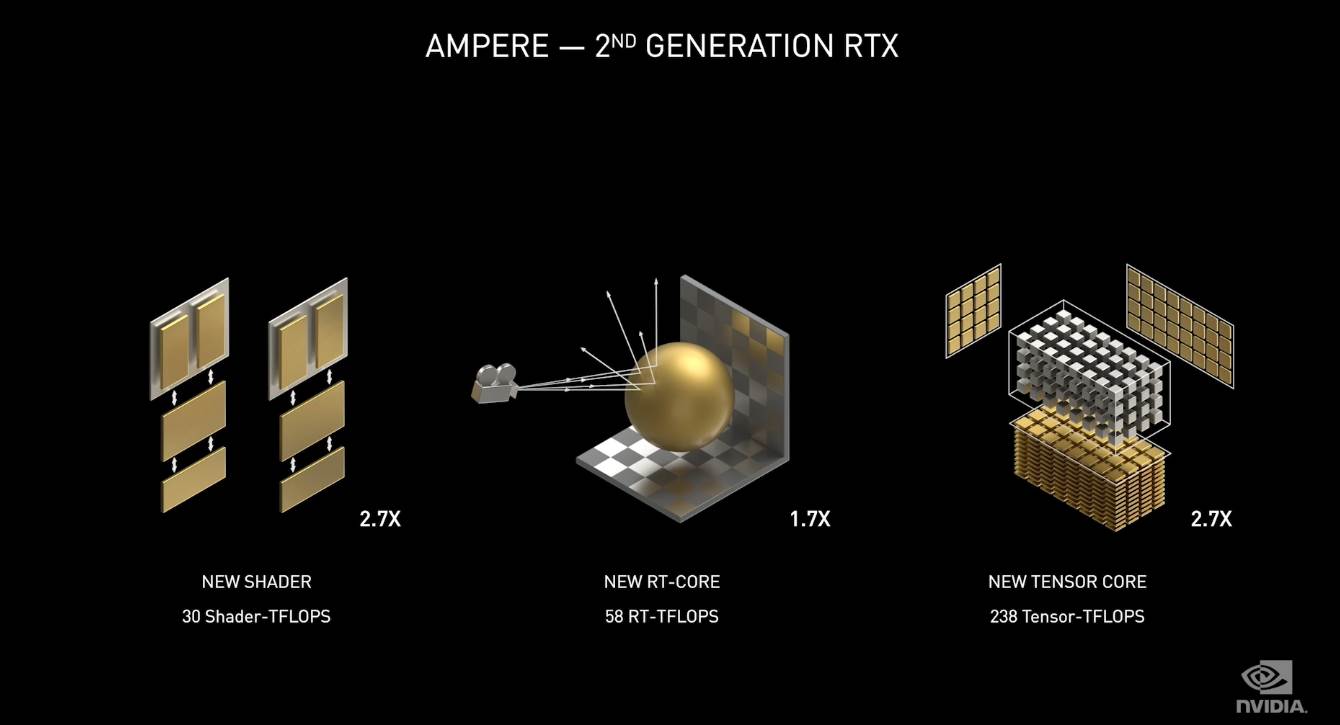

Más que pensar en traer novedades tecnológicas, Ampere se centra en mejorar todo lo nuevo que trajo Turing. Y es que la primera generación de RTX era sensacional, pero se notaba que todavía quedaba mucho por hacer, y Ampere viene para mejorar eso.

La salida de Turing dejó una conclusión importante: «RTX es el futuro, pero no el presente». Ahora, Ampere es ese futuro, o se acerca.

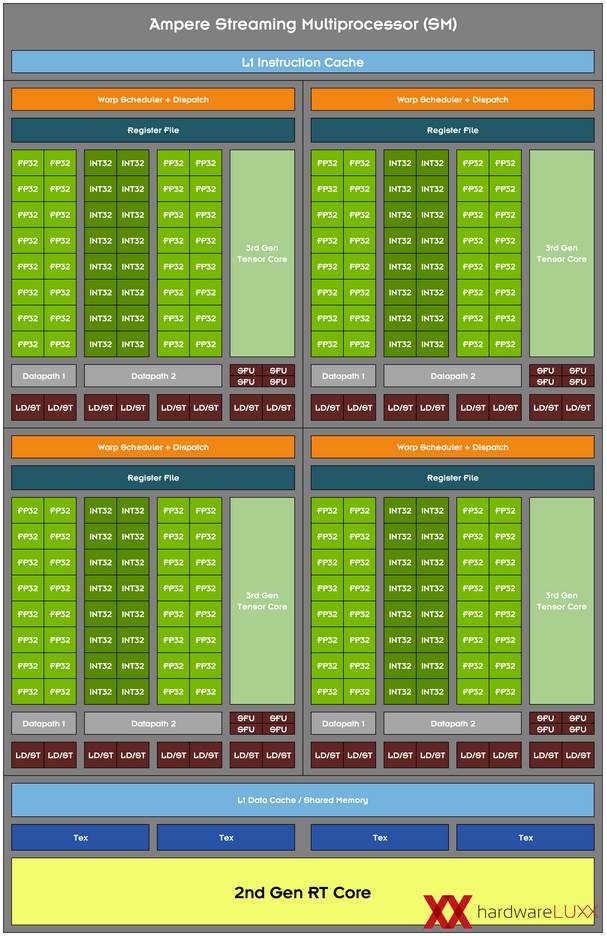

Pues bien, dentro de ese contexto, la nueva arquitectura optimiza el rendimiento de los núcleos RT y Tensor, hasta doblar sus capacidades en cada uno de ellos respecto a Turing.

Pues bien, dentro de ese contexto, la nueva arquitectura optimiza el rendimiento de los núcleos RT y Tensor, hasta doblar sus capacidades en cada uno de ellos respecto a Turing.

Ampere tiene 3 puntos clave, los dos primeros te los acabamos de decir y el tercero es un nuevo diseño del camino de datos interno de los núcleos CUDA, en los que en vez de tener 1 parte para ejecución de operaciones con enteros (INT32) y otra para números de coma flotante de precisión simple (FP32), ahora en la parte de INT32 hay un camino aparte para FP32. Así, se consigue que en aplicaciones donde se hagan cálculos con este tipo de números se obtenga el doble de rendimiento.

En cambio, si tu programa solo hace FP32, ahora tienes la opción de obtener el doble de rendimiento.

Ampere también avanza, como cada generación, en el rendimiento por vatio, es decir, la eficiencia energética. Sin embargo, el aumento en rendimiento ha sido mucho mayor a esto último, lo que implica la mala noticia de que las gráficas Ampere consumen más que sus sucesoras. ¡Bastante más, de hecho!

Grandes cambios en las Founders Edition

No podemos hablaros de NVIDIA Ampere sin mencionar los tremendos cambios que marcaron a las Founders Edition, que son básicamente los modelos de referencia que vende la propia NVIDIA. Básicamente, la compañía ha revolucionado la refrigeración en tarjetas gráficas, con la inclusión de un interesante sistema donde cada uno de los dos ventiladores está a un lado de la GPU. Así, uno mete aire fresco de la parte inferior de la caja directamente hacia donde está el núcleo, mientras que el otro se dedica a sacar el aire caliente que queda en el disipador de aluminio.

No podemos hablaros de NVIDIA Ampere sin mencionar los tremendos cambios que marcaron a las Founders Edition, que son básicamente los modelos de referencia que vende la propia NVIDIA. Básicamente, la compañía ha revolucionado la refrigeración en tarjetas gráficas, con la inclusión de un interesante sistema donde cada uno de los dos ventiladores está a un lado de la GPU. Así, uno mete aire fresco de la parte inferior de la caja directamente hacia donde está el núcleo, mientras que el otro se dedica a sacar el aire caliente que queda en el disipador de aluminio.

Estos cambios responden a una excelente evolución por parte de NVIDIA, que por fin había abandonado sus ineficientes diseños de refrigeración de turbina en la pasada generación.

Estos cambios responden a una excelente evolución por parte de NVIDIA, que por fin había abandonado sus ineficientes diseños de refrigeración de turbina en la pasada generación.

Además de esto, otra innovación de las nuevas Founders Edition estuvo presente en el sistema de alimentación, ya que se pasó a emplear un conector de alimentación totalmente nuevo, de 12 pines, basado en el diseño Molex MicroFit.

Además de esto, otra innovación de las nuevas Founders Edition estuvo presente en el sistema de alimentación, ya que se pasó a emplear un conector de alimentación totalmente nuevo, de 12 pines, basado en el diseño Molex MicroFit.

La gran característica diferencial de dicho conector fue su pequeñísimo tamaño. Ahora, con un único conector de un tamaño más pequeño que uno de 8 pines se puede dar la capacidad de alimentación equivalente a dos de ellos.

El gran punto negativo viene derivado de la necesidad de emplear adaptadores a los conectores de alimentación estándar, siempre y cuando nuestra fuente no los tenga de por sí, que no es el caso ya que ningún fabricante ha adaptado sus modelos a dicho conector, más allá de que puedan vender algún cable completo por separado. Afortunadamente, esto solo ocurrió en los modelos Founders, y no en los personalizados.

El gran punto negativo viene derivado de la necesidad de emplear adaptadores a los conectores de alimentación estándar, siempre y cuando nuestra fuente no los tenga de por sí, que no es el caso ya que ningún fabricante ha adaptado sus modelos a dicho conector, más allá de que puedan vender algún cable completo por separado. Afortunadamente, esto solo ocurrió en los modelos Founders, y no en los personalizados.

Línea de gráficas RTX 3090, RTX 3080 y RTX 3070: especificaciones y rendimiento

Vamos a ver ahora cómo es la línea completa de tarjetas gráficas RTX 3090, 3080 y 3070 de la serie Ampere.

Vamos a ver ahora cómo es la línea completa de tarjetas gráficas RTX 3090, 3080 y 3070 de la serie Ampere.

| NVIDIA GeForce RTX 3070 | NVIDIA GeForce RTX 3080 | NVIDIA GeForce RTX 3090 | |

| Arquitectura / Proceso de fabricación | NVIDIA Ampere / Samsung 8nm | ||

| Chip | GA104-300 | GA102-200 | GA102-300 |

| Núcleos CUDA | 5888 | 8704 | 10496 |

| RT Cores | 46 | 68 | 82 |

| Tensor Cores | 184 | 272 | 328 |

| SM | 46 | 68 | 82 |

| Reloj base | 1500 MHz | 1440 MHz | 1400 MHz |

| Reloj boost | 1730 MHz | 1710 MHz | 1700 MHz |

| Memorias | 8GB GDDR6 | 10GB GDDR6X | 24GB GDDR6X |

| Frecuencia memorias (Gbps) | 14 Gbps | 19 Gbps | 19.5 Gbps |

| Ancho de bus | 256 bits | 320 bits | 384 bits |

| Cómputo FP32 Base / Boost | 17.7 / 20.3 TFLOPS | 25.07 / 29.8 TFLOPS | 29.4 / 35.7 TFLOPS |

| Tensor FLOPS | 81.3 | 119 | 142 |

| TGP | 220W | 320W | 350W |

| Soporte NVLink | No | Sí, dos vías | |

| Fecha de lanzamiento | 29 de octubre de 2020 | 17 de septiembre de 2020 | 24 de septiembre de 2020 |

| Precio de salida | 499$ | 699$ | 1499$ |

Respecto a su rendimiento, tenemos gráficas muy solventes para jugar a resoluciones 1440p y 4K, donde en función del juego podemos obtener rendimientos inmensos, sobre todo si nos valemos de tecnologías como DLSS. Usando esta última podemos llegar a obtener una buena jugabilidad a resolución 8K. Evidentemente queda mucho para hacerlo a resolución nativa.

Vemos aquí cómo el salto generacional de la RTX 2080 Ti a la 3080 ha sido bastante considerable, una muy buena noticia para el mercado, máxime cuando tras este lanzamiento AMD consiguió alcanzarles con sus Radeon RX 6000.

Pues bien, una vez visto esto, concluimos que las RTX 3090 no son opciones interesantes en gaming, ya que están más bien pensadas para aprovechar su potencia bruta, con la RTX 3080 siendo una interesante opción para jugar a 4K con los máximos FPS posibles, y una 3070 muy fuerte en el mercado de gama media-alta.

NVIDIA dio un salto generacional excelente de las RTX 20 a las RTX 30. A su vez, AMD consiguió alcanzar el rendimiento de las NVIDIA tope de gama. Competencia e innovación unidas, una excelente noticia, aunque vamos a ver ahora que no todo fue tan bonito.

Los problemas de lanzamiento y de stock de Ampere

Es realmente difícil que un lanzamiento de una nueva arquitectura gráfica salga bien desde el principio. Aunque AMD se lleve casi toda la mala fama en este sentido (injustamente) NVIDIA no se salva, igual que no se salvó en las primeras semanas de Pascal y Turing.

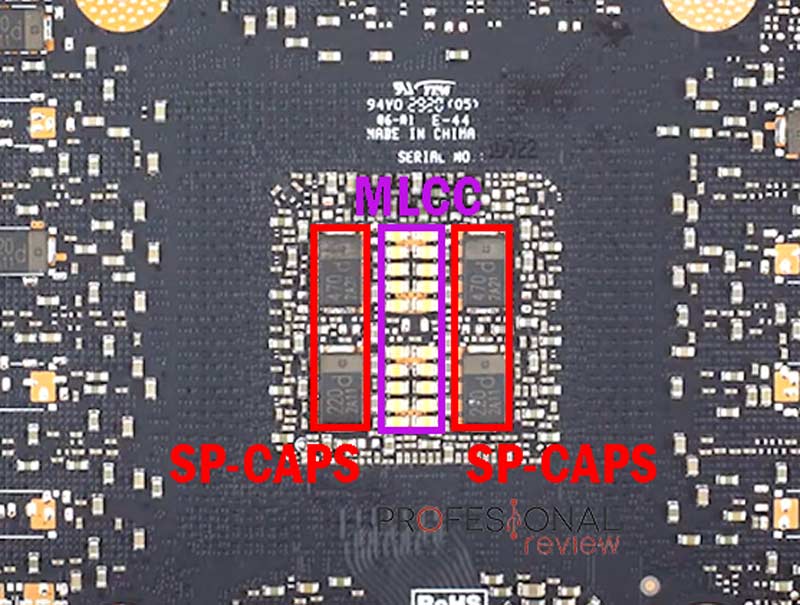

En el caso de Ampere, la gran polémica llegó cuando sus tarjetas gráficas sufrían crasheos bastante importantes en juegos, un hecho que parecía ocurrir mayormente en algunos modelos concretos, pues por ejemplo no pasaba en las Founders Edition. Ante esto, se lanzó la alarma de que se debería a un filtrado insuficiente en la energía que llegaba al chip de la GPU.

Después de días de incertidumbre e investigaciones, al final se supo que el problema tenía que ver específicamente con los drivers de la gráfica. Básicamente, el algoritmo de boost de NVIDIA tenía picos de frecuencia demasiado exagerados, que simplemente estos modelos no eran capaces de aguantar. Afortunadamente, se acabó solventando, pero es una buena prueba de que las cosas a veces no tienen por qué salir bien.

Lo que sí impactó todavía más a esta nueva generación de NVIDIA RTX fue su disponibilidad en el mercado. Durante los primeros meses tras el lanzamiento, su disponibilidad en tiendas fue tremendamente limitada: a una demanda elevada, como es de esperar en cada arquitectura gráfica nueva, había que sumarle unas grandes carencias de stock. No solo se derivaron de la mala época en que se lanzaron, donde la cadena de suministro estaba bastante estresada en general, sino que tuvieron problemas específicos derivados del proceso de fabricación de Samsung a 8nm que se estaba utilizando, y que parece no dar muy buenos resultados: son muchos los chips que no dan la talla y se tienen que descartar, así que hay muchas carencias en este sentido.

Ya entrados en 2021 y 2022, estos problemas quedaron en un segundo plano ya que NVIDIA mantuvo un stock muy amplio y unos precios algo más razonables.

NVIDIA RTX 40, Ada Lovelace revoluciona el rendimiento

La siguiente generación de tarjetas gráficas NVIDIA GeForce RTX llegó bajo la arquitectura Ada Lovelace, y se presentaron en septiembre de 2022, justo 2 años después del lanzamiento de RTX 30, tal y como es habitual.

Pues bien, las tarjetas gráficas Ada se basan en los siguientes cambios principales:

- Un aumento del 71% en el número de streaming multiprocessors (SM) en el mejor chip (AD102) respecto al mejor de Ampere (GA102), pasando de 10752 a 18432 núcleos CUDA.

- Este cambio se hace posible con la mejora del proceso de fabricación, que pasa a los 5nm FinFET de TSMC.

- El rendimiento del ray tracing se mejora considerablemente.

- Se optimiza la caché L2 para traer a NVIDIA el espíritu de AMD Infinity Cache.

- Presentan DLSS 3 con Frame Generation, un salto muy grande en las capacidades y rendimiento de DLSS.

- Soportan AV1 por hardware.

Así, la mejora de rendimiento ha sido bestial con estas nuevas tarjetas gráficas, «noqueando» por completo a AMD, que intentó batir a NVIDIA con su RX 7900 XTX.

Serie de tarjetas gráficas NVIDIA GeForce RTX 40 para escritorio

La mejora de rendimiento de esta generación es simplemente brutal en la gama alta: la RTX 4090 es un 66% mejor que la RTX 3090, un 45% mejor que la 3090 Ti, y ya de paso un 24% mejor que la 7900 XTX de AMD. Todo esto sin comentar las mejoras tecnológicas de DLSS con Frame Generation.

NVIDIA continuó lanzando sus tarjetas gráficas y las mejoras en los segmentos más bajos han sido ligeramente más discretas, por ejemplo de la RTX 3060 a la RTX 4060 la mejora es de alrededor de un 20%.

Pues bien, en la siguiente tabla te dejamos la línea de NVIDIA RTX 40 lanzadas al mercado.

| RTX 4090 | RTX 4080 | RTX 4070 Ti | RTX 4070 | RTX 4060 Ti 16GB | RTX 4060 Ti 8GB | RTX 4060 | |

|---|---|---|---|---|---|---|---|

| Arquitectura | Ada Lovelace, fabricada bajo TSMC 5nm | ||||||

| Núcleos CUDA | 16384 | 9728 | 7680 | 5888 | 4352 | 3072 | |

| Frecuencia boost | 2.52 GHz | 2.51 GHz | 2.61 GHz | 2.48 GHz | 2.54 GHz | 2.46 GHz | |

| Cantidad VRAM | 24GB | 16GB | 12GB | 16GB | 8GB | ||

| Tipo VRAM | GDDR6X | GDDR6 | |||||

| TBP | 450W | 320W | 285W | 200W | 165W | 160W | 115W |

| Fecha lanzamiento | Octubre 2022 | Noviembre 2022 | Enero 2023 | Abril 2023 | Julio 2023 | Mayo 2023 | Julio 2023 |

| Precio de salida (MSRP) | 1599$ | 1199$ | 799$ | 599$ | 499$ | 399$ | 299$ |

Lo siguiente que está por venir son las NVIDIA GeForce RTX 40 SUPER, cuyo lanzamiento se espera para enero de 2024, que cubrirán algunos huecos situados entre la RTX 4070 y la RTX 4090.

Con esto finaliza nuestro artículo especial dedicado a las nuevas tarjetas gráficas Nvidia RTX, recuerda que puedes dejar un comentario si tienes alguna sugerencia o algo que añadir. También puedes compartir el artículo con tus amigos en las redes sociales, de esta forma nos ayudas a difundirlo para que pueda llegar a más usuarios que lo necesiten. ¿Qué piensas de la llegada del Ray Tracing a las nuevas tarjetas gráficas de Nvidia? ¿Crees que seguirá marcando el futuro de las GPU?